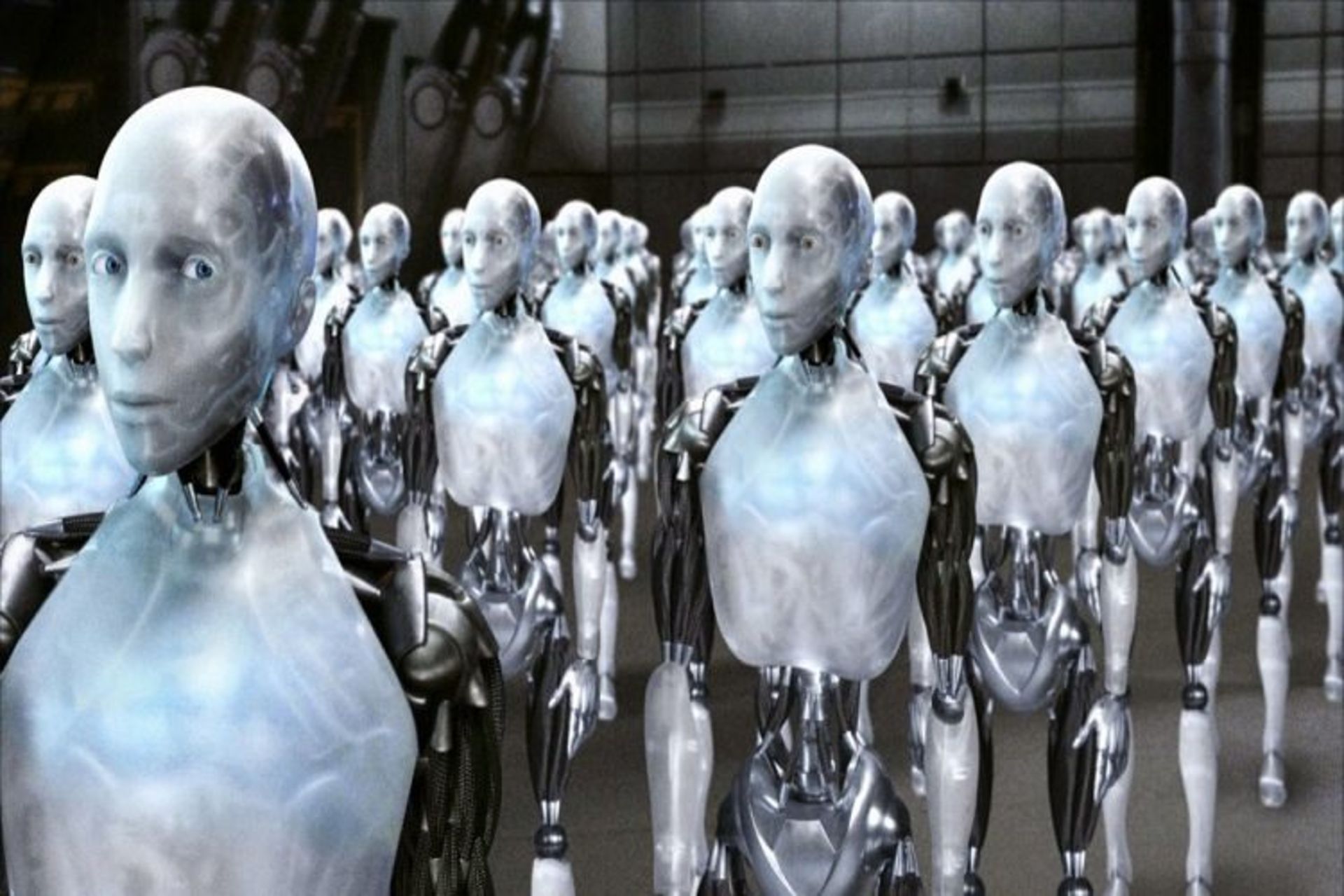

آیا رباتها در آینده قادر به سرپیچی از انسان خواهند بود؟

شاید تلاش مهندسان جهت تعلیم رباتها برای سرپیچی کردن از فرامین انسانها در ابتدا کمی نگرانکننده به نظر برسد. آیا واقعا باید برای سیستمهای هوش مصنوعی آینده، امکان سرپیچی از دستورات را فراهم کنیم؟ اما با کمی تفکر میتوان به این نتیجه رسید که ویژگی یاد شده میتواند از بروز حوادث زیادی جلوگیری کند و در حقیقت ناجی جان انسانها باشد.

رباتی را تصور کنید که در خط تولید یک شرکت خودروسازی مشغول فعالیت است: این ربات در شرایط عادی باید از فرامین و دستورات از پیش تعیین شدهای پیروی کند؛ اما در صورتی که جان انسانی در خطر باشد ربات یاد شده باید به اندازهای هوشمند باشد که با هدف کاهش احتمال وقوع حادثه، انجام وظایف پیشفرض خود را متوقف کند. برای دستیابی به چنین قابلیتی، یک تیم از لابراتوار تعامل انسان و ربات در دانشگاه تافتس تحقیقات خود را آغاز کردهاند.

اساس کار این تیم برمبنای شروط Felicity تشکیل شده است. مغز انسان نیز برای تصمیم گیری در مورد وظایف محول شده، بر مبنای همین شروط عمل میکند. براساس این شروط ما قبل از اقدام به انجام کاری به صورت ناخوداگاه، موارد زیر را در نظر میگیریم: آیا با نحوهی انجام این کار آشنا هستم؟ آیا از لحاظ فیزیکی امکان انجام آن را دارم و میتوان اکنون انجامش دهم؟ آیا بر اساس نقش خود در اجتماع موظف به انجام این کار هستم؟ و در پایان، آیا با انجام این کار، هنجاری را نقض میکنم؟

اگر رباتها قادر به پرسیدن این سوالات از خود باشند، در نهایت قادر به سازگار کردن خود با شرایط غیر منتظره خواهند بود. دو سوال پایانی، نقشی کلیدی در این فرآیند ایفا میکنند. یک ربات باید قادر به تشخیص صلاحیت اپراتور خود باشد؛ علاوه بر این باید امکان بررسی پیامدهای انجام دستورات داده شده توسط اپراتور را داشته باشد و در صورتی که دستوری در نهایت منجر به وارد آمدن صدمه به خود یا دیگران و در حالت کلی بروز حادثهای شود، از انجام آن سرپیچی کند. عملی کردن این ایده کار بسیار دشواری است.

در دموی منتشر شده توسط این تیم، مهندسان در حال تست تعدادی مکالمهی ساده بین ربات و کاربر هستند که امکان انجام چند داد و ستد ساده را فراهم میکند. این به مفهوم آن است که ربات میتواند دلایلی را برای انجام ندادن کاری فراهم کند؛ در حالی که اپراتور میتواند دلایل بیشتری برای انجام دستورات توسط ربات بیاورد. به عنوان مثال در این دمو، ربات میگوید که در صورت پیشروی به سمت لبهی میز، سقوط خواهد کرد. اما در ادامه و با کسب اطمینان خاطر از جانب اپراتور به حرکت خود ادامه میدهد و در لحظهی رسیدن به لبهی میز، اپراتور آن را میگیرد.

محققین توسعهدهندهی خودروهای خودران نیز با مسئلهی مشابهی درگیر هستند؛ اگر خودروی خودران در یک موقعیت بحرانی گرفتار شود که در طی آن جان چندین انسان تهدید میشود، آیا عمدا مسیر خود را تغییر داده و با برخورد با یک دیوار جان تنها سرنشین خود را به خطر میاندازد، یا با طی مسیر فعلی خود و در نهایت برخورد با جمعیت منجر به مرگ یا جراحت افراد بیشتری می شود؟

تحقیقات نشان میدهد که عموم مردم با به حداقل رسیدن تلفات موافق هستند؛ حتی اگر این به مفهوم مرگ سرنشین خودرو باشد. طبق مقالهای که اخیرا منتشر شده، اگرچه فراهم کردن امکان سرپیچی از فرامین در رباتها به صورت بالقوه میتواند خطرآفرین باشد، اما در حقیقت تبعیت کورکورانه رباتها از فرامین، امکان وقوع حوادث بیشتری را به دنبال دارد.

در این مقاله چنین آمده است:

انسانها به دلایل مختلفی از دستورات سرپیچی میکنند؛ این دلایل میتوانند مجموعهی گستردهای را از ناتوانی در انجام دستورات تا تردیدهای اخلاقی در مورد پیامدهای انجام آنها را شامل شوند. حلقهی گمشده در معماری ادراکی رباتها، مجموعهای از مکانیزمهای یکپارچه برای فراهم کردن امکان تصمیمگیری برای پذیرش یا رد دستورات با در نظر گرفتن تمامی احتمالات و در نهایت فراهم کردن توضیحی قانع کننده در مورد دلیل انجام ندادن دستور توسط ربات است.

در پایان از شما دعوت میکنیم تا دموی منتشر شده توسط تیم تحقیقاتی دانشگاه تافتس را تماشا کنید: