آنتروپیک؛ رقیب جدی OpenAI که میخواهد امنترین هوش مصنوعی را بسازد

سهشنبه ۳۰ مرداد ۱۴۰۳ - ۱۰:۰۰مطالعه 16 دقیقهتابستان سال ۲۰۲۲، داریو آمودی (Dario Amodei) بنیانگذار و مدیرعامل استارتاپ هوش مصنوعی آنتروپیک بر سر دوراهی سختی قرار گرفت.

تیم او بهتازگی تعلیم چتبات جدیدی را به پایان رسانده بود که بسیار قدرتمندتر از محصولات روز هوش مصنوعی عمل میکرد و حتی خود اعضای تیم که در دفتر مرکزی آنتروپیک مستقر در سانفرانسیسکو مدتها روی این مدل کار میکردند، از محصول خود بسیار متحیر و شگفتزده بودند.

آمودی میدانست که با انتشار کلود میتواند برای آنتروپیک، استارتاپی با ۵۰ کارمند که سال قبل راهاندازی شده بود، شهرت و ثروت مطلوبی به دست آورد؛ اما او عمیقاً نگران عواقب احتمالی «رهاکردن» هوش مصنوعی در جهان بود. درواقع او بهقدری نگران بود که پس از شبها بیخوابی، تصمیم گرفت کلود را معرفی و عرضه نکند و بهجای آن به آزمایشهای ایمنی چتبات ادامه دهد.

دقیقاً سه ماه بعد، آزمایشگاه OpenAI محصول مشابهی را با نام ChatGPT عرضه کرد و به دنبال آن موج دیوانهواری از هیاهو و سرمایهگذاری روی هوش مصنوعی به راه افتاد و کل صنعت فناوری را متحول کرد.

بسیاری از کارآفرینان سیلیکونولی چنین فرصت ازدسترفتهای را برای حسرت تمامی عمر خود کافی میدانند؛ اما این انتخاب سخت برای آمودی چیزی فراتر از تجارت و کسبوکار بود: او میخواست از راهافتادن مسابقهای جدید برای ساختن سیستمهای هوش مصنوعی بزرگتر و شاید خطرناکتر جلوگیری کند.

بااینحال رقابتی که آمودی از آن پرهیز داشت، شروع شد و احتمالاً میلیاردها دلار هزینه به این استارتاپ تحمیل کرد. ولی ظهور ChatGPT رگولاتورها را متوجه موضوعی کرد که آمودی سالها نگرانش بود: اگر هوش مصنوعی پیشرفته بهطور ضعیفی مدیریت شود، میتواند بهطرز فاجعهباری خطرناک باشد.

آمودی در ماه جولای ۲۰۲۴، در مجلس سنای آمریکا طی جلسهای که مدیران شرکتهای مطرح فناوری در آن حضور داشتند، شهادت داد و گفت:

تا سال ۲۰۲۵ امکان ساخت سیستمهای هوش مصنوعی که به آن اندازه قدرتمند باشند که در مقیاس وسیع ویرانی به بار آورند و توازن قوای کشورهای مختلف را تغییر دهند، فراهم میشود.

در این مطلب میخواهیم نگاهی نزدیکتر به تاریخچه، محصولات و فلسفهی کار استارتاپ آنتروپیک داشته باشیم، پس در ادامه با ما همراه باشید.

تاریخچه تأسیس آنتروپیک

استارتاپ آنتروپیک ژانویهی ۲۰۲۱ توسط ۷ کارمند سابق شرکت OpenAI ازجمله دو خواهر و برادر، دانیلا آمودی و داریو آمودی تأسیس شد. داریو پیشازاین سمت معاون ارشد تحقیقات را در شرکت اوپن ایآی بهعهده داشت و نقشی کلیدی در توسعهی شبکههای عصبی GPT-2 و GPT-3 ایفا کرده بود.

این ۷ نفر که همگی از متخصصان و محققان عالیرتبهی هوش مصنوعی بودند، در پی اختلافنظرهایی که بین کارکنان و مدیریت OpenAI بهوجود آمد، از این شرکت جدا شدند. یکی از دلایل اصلی تصمیم آنها، ریشه در سرمایهگذاری سنگین مایکروسافت در این شرکت در سال ۲۰۱۹ و شروع پروژههای مشترک و جدید آنها داشت. آنها میترسیدند سرمایهگذاری مایکروسافت باعث تجاریشدن دستاوردهای هوش مصنوعی شرکت شود.

آنتروپیک توسط ۷ متخصص سابق شرکت OpenAI تأسیس شد

این گروه معتقد بودند احتمال اینکه «سیستمهای هوش مصنوعی طوری از کنترل خارج شوند که به بشریت آسیب برسانند یا برای اهداف مجرمانه مورد استفاده قرار گیرند»؛ وجود دارد. از نظر آنها در چنین شرایطی، دیگر کاری از دست توسعهدهندگان مدلهای AI بر نمیآید.

برخی معتقدند باتوجهبه سوابق درخشان حرفهای و دیدگاه فلسفی آمودی در زمینهی فناوریهای هوش مصنوعی، شاید این جدایی دور از انتظار نبود: داریو آمودی پس از اینکه دکترای فیزیک خود را از دانشگاه پرینستون گرفت، کارش را بهعنوان محقق یادگیری ماشین آغاز کرد. او سال ۲۰۱۶ به اوپنایآی ملحق شد و نقش مهمی در کشف قوانین مقیاسپذیری داشت.

داریو نشان داد که بهجای تکیهکردن به الگوریتمهای جدید، میتوان با آموزش سیستمهای هوش مصنوعی با دادهها و قدرت محاسباتی بیشتر، به عملکرد بهتری دست یافت. حتی در همان دوران نیز آمودی نگران بود که اگر این فاکتورها با انگیزهها و مشوقهای بازاری همراه شوند، امنیت مدلها را تضعیف خواهند کرد. او در همان دوران گفته بود:

ما در حال ساختن فناوری قدرتمند و بالقوه خطرناکی هستیم که از اجزای ساده ساخته شده است و هر کسی که پول کافی داشته باشد، میتواند نمونهی آن را بسازد.

هرچند آمودی شخصاً از احساسی که نسبت به مدیران اوپنایآی داشت صحبت نکرد، ولی به گفتهی همکاران نزدیکش، او به سم آلتمن مدیرعامل شرکت و گرگ براکمن رئیس هیئتمدیره اعتماد نداشت.

مدت کمی پس از اینکه او و شش کارمند ردهبالای شرکت استعفا دادند، هفت نفر دیگر از کارکنان OpenAI نیز به آنها پیوستند. او در مورد بنیانگذاران و ترک شرکت سابق خود بسیار باسیاست صحبت میکند:

همهچیز به اعتماد، ارزشهای یکسان و همسویی مأموریت افراد برمیگردد. تا پیش از سرمایهگذاریهای کلان، همهی ما متخصصان و بنیانگذاران OpenAI هممسیر بودیم، به یکدیگر اعتماد داشتیم و کارمان را با دلایل درستی انجام میدادیم.

ایدهی اولیهی استارتاپ

استارتاپ تازهتأسیس آمودی و همکارانش ابتدا آزمایشگاه ایمنی هوش مصنوعی نام داشت و سپس به آنتروپیک تغییر نام داد. ایدهی اولیهی فعالیت استارتاپ این بود که اعضای تیم مدلهای آمادهی هوش مصنوعی را از توسعهدهندگان دیگر بهعنوان مبنایی بگیرند و امنیت آنها را آزمایش کنند.

بنیانگذاران آنتروپیک معتقدند هوش مصنوعی تحت مدیریت ضعیف، میتواند به بشریت آسیب بزند

مدتی نگذشته بود که آمودی و تیمش متوجه شدند برای پروژهی خود باید سیستم عصبی قدرتمندی را از ابتدا راهاندازی کنند. توسعهی مدل هوش مصنوعی آنتروپیک با تعهد داخلی اعضا به این اصل آغاز شد: «هوش مصنوعی باید بهگونهای توسعه یابد که در خدمت بشر و تحت کنترل او باشد، نه اینکه بهطور تصادفی یا غیرقابل پیشبینی عمل کند.»

مدل زبانی آنتروپیک به یاد ریاضیدان مشهور کلود شانون، کلود نام گرفت.

چالشهای اولیه و جذب سرمایه

شروع کار روی شبکهی عصبی داخلی، به بودجهای نیاز داشت که مسلماً از عهدهی بنیانگذاران آنتروپیک بر نمیآمد. آنها برای خرید میلیونها پردازندهی فوقالعاده قدرتمند که لازمهی آموزش مدلهای هوش مصنوعی است، باید نظر سرمایهگذارانی را جلب میکردند که به هدف بلندمدت آنتروپیک بها دهند.

یکی از اولین سرمایهگذاران استارتاپ، بخش ابری شرکت گوگل بود که با سرمایهگذاری ۳۰۰ میلیوندلاری، ۱۰ درصد از سهام پروژه را در اختیار گرفت. یکی از شرایط مهم قرارداد نیز این بود که آنتروپیک در فرایندهای خود از منابع محاسباتی ابری گوگل استفاده کند.

آوریل سال ۲۰۲۲ آنتروپیک مبلغی معادل ۷۰۰ میلیون دلار افزایش سرمایه داشت که ۵۰۰ میلیون دلار آن را Alameda Research یکی از شرکتهای تابعهی صرافی معروف و حالا ورشکستهی FTX تأمین کرد.

ماه می سال ۲۰۲۳، تأمین مالی توسعهی شبکه عصبی نوآورانهی Anthropic AI Claude با جذب ۴۵۰ میلیون دلار از سه شرکت ملنو ونچرز، اسپارک کپیتال و ساوند ونچرز ادامه یافت. همچنین پلتفرم ارتباطی «زوم» و بازوی سرمایهگذاری شرکت سیلزفورس نیز در این دوره روی آنتروپیک سرمایهگذاری کردند.

سپتامبر ۲۰۲۳، آمازون برنامههای خود را برای حمایت مالی از آنتروپیک با مبلغ خیرهکنندهی ۴ میلیارد دلار اعلام کرد. بهموجب این قرارداد خدمات وب آمازون (AWS) منبع اصلی خدمات محاسبات ابری این استارتاپ تبدیل میشد و شرکت آمازون نیز سهام اقلیت آنتروپیک را دریافت میکرد. اولین قسط این سرمایهگذاری ۱٫۲۵ میلیارد دلار بود.

آمازون با سرمایهگذاری ۴ میلیارد دلاری بزرگترین حامی مالی آنتروپیک محسوب میشود

بهموجب قرارداد آمازون و آنتروپیک؛ توسعهدهندگان شبکههای عصبی این استارتاپ از تراشههای سفارشیسازیشدهی AWS برای ساخت، آموزش و استقرار مدلهای هوش مصنوعی استفاده میکنند. همچنین هر دو شرکت در پروژههای توسعهی تراشههای جدید هوش مصنوعی با هم همکاری خواهند کرد.

حتی زمانی که مجموع سرمایهی جمعآوریشدهی آنتروپیک به ۷ میلیارد دلار و تعداد کارمندان شرکت به ۵۰۰ نفر رسید و سه نسل از چتباتهای کلود راهاندازی شد، هنوز هم آنتروپیک کوچکترین و جوانترین شرکت میان بازیگران اصلی و خط مقدم هوش مصنوعی محسوب میشد؛ شرکتی که به نسبت سایر رقبا هنوز هم از کمترین منابع مالی بهره میبرد و دستکم به ادعای خودشان، متعهدترین آنها به امنیت هوش مصنوعی بود.

آنتروپیک و فلسفهی نوعدوستی مؤثر

تعدادی از کارمندان و سرمایهگذاران اولیهی آنتروپیک، بهنوعی با جنبش نوعدوستی مؤثر (Effective Altruism) همراه بودند. این فلسفه که در سالهای اخیر محبوبیت زیادی در سیلیکونولی پیدا کرده است، احتمال نابودی بشریت توسط هوش مصنوعی را مطرح میکند.

هواداران این جنبش تأکید دارند که باید مطالعهی خطرات فاجعهبار ناشی از هوش مصنوعی را جدی گرفت. بسیاری از اعضای جامعهی هوش مصنوعی (البته نه همه)، با درجات مختلف از این نظریه پیروی میکردند.

واقعهای که باعث شد جنبش نوعدوستی مؤثر در طول یک و نیمسال اخیر جنجالبرانگیز شود، رسوایی کلاهبرداری غول ارزهای دیجیتال سام بنکمن فرید بود که همیشه خود را به نوعدوستی مؤثر مقید نشان میداد. بنکمن که در حال حاضر در حال گذراندن حکم ۲۵ سال محکومیت خود در زندان است، از طریق شرکت FTX و با واسطهی Alameda Research حدود ۵۰۰ میلیون دلار در آنتروپیک سرمایهگذاری کرده بود.

جنبش نوعدوستی مؤثر، مطالعهی خطرات فاجعهبار ناشی از هوش مصنوعی را ضروری میداند

پس از این ماجرا در ماه مارس ۲۰۲۴، بخش اعظم سهام FTX به کنسرسیومی از سرمایهگذاران فروخته شد و باقی آن نیز در اختیار FTX Estate قرار گرفت تا زیان سرمایهگذاران فریبخورده را جبران کند.

اما افتیایکس تنها شرکت پیرو نوعدوستی مؤثر نبود که از آنتروپیک حمایت کرده بود. داستین موسکوویتز، همبنیانگذار فیسبوک و جان تالین بنیانگذار اسکایپ نیز از جمله سرمایهگذاران این شرکت پیشروی هوش مصنوعی هستند که پیوندهای محکمی با این فلسفه دارند.

مشخصاً ریشههای نوعدوستی مؤثر در آنتروپیک بسیار عمیقتر از آزمایشگاههای هوش مصنوعی رقیب است، هرچند با افزایش تعداد کارکنان استارتاپ به بیش از ۵۰۰ نفر، این مُهر تا حدودی کمرنگتر شده است. به گفتهی سخنگوی آنتروپیک، نه داریو و نه دانیلا هرگز شخصاً بخشی از جامعهی این جریان فلسفی نبودهاند، اما هر دو بهوضوح از برخی ایدههایی که زمینهساز نوعدوستی مؤثر محسوب میشوند، حمایت میکنند.

ساختار عامالمنفعهی شرکت

در هر صورت اعتقاد اعضای آنتروپیک به ماهیت تحولآفرین هوش مصنوعی، بنیانگذاران را بر آن داشت تا ساختار شرکت جدید خود را متفاوت از شرکتی که ترک کرده بودند، بنا نهند.

بدین ترتیب آنتروپیک بهعنوان یک شرکت عامالمنفعه به جهان معرفی شد، به این معنی که هیئتمدیره از نظر قانونی مسئول متوازن کردن سود سرمایهگذاران هستند و همزمان مأموریت دارند که اطمینان حاصل کنند «هوش مصنوعی به شکوفایی مردم و جامعه کمک میکند.»

از طرف دیگر تیمی از کارشناسان توسعهی بینالمللی، ایمنی هوش مصنوعی و امنیت ملی با نام Long Term Benefit Trust قدرت انتخاب و اخراج زیرمجموعهای از هیئتمدیره را دارد. این افراد هیچ سهامی در شرکت ندارند.

به گفتهی مدیران شرکت این سیستم منافع مردم و کارمندان و سرمایهگذاران را بهگونهای همسو میکند که ثبات آنتروپیک را حفظ کند و همچنین به شرکت اجازه میدهد در صورت لزوم، امنیت را نسبت به سودآوری در اولویت قرار دهند.

هیئتمدیره آنتروپیک از نظر قانونی باید ایمنی هوش مصنوعی را نسبت به سود سهامداران در اولویت قرار دهد

با این حساب ساختار آنتروپیک با OpenAI تفاوتهایی اساسی دارد، ولی نکته اینجا است که حتی در سیستم عامالمنفعه نیز قدرت نهایی در اختیار گروهی انگشتشمار است. اگرچه قوانین فوق تاحدودی اعضای هیئتمدیره را از شکایت سهامداران مصون نگه میدارد، ولی مشخص نیست که آیا خود مردم هم میتوانند از هیئتمدیره به دلیل اولویتندادن به امنیت شکایت کنند یا خیر.

معرفی مدلهای Claude

ماه مارس ۲۰۲۳ آنتروپیک اولین مدل هوش مصنوعی خود را در دو نسخه معرفی کرد: Claude و Claude Instant با این توضیح که نسخهی اینستنت، سبکتر از نسخهی اصلی کلود ۱ است. آنتروپیک حتی در انتخاب نام مدلهای زبانی بزرگ خود نیز برخلاف جریان نامگذاری دستیارهای مجازی که غالباً نامی زنانه داشتند (مانند الکسا، سیری و کورتانا) عمل کرد.

مدلهای کلود بر اساس معماری ترنسفورمر گوگل توسعه یافتند و مشابه دیگر مدلهای زبانی مانند GPT، با حجم بسیار زیادی از دادههای متنی تعلیم دیدند، اما تمرکز ویژهای بر تولید پاسخهای ایمن و غیرمتعصابانه داشتند.

کلود ۱ توانایی درک و تولید متن را داشت و میتوانست در حوزههای مختلف مانند تولید محتوا، پاسخگویی به سؤالات، و حتی تعاملات پیچیده انسانی استفاده شود؛ اما در مقایسه با مدلهای زبانی دیگر مانند GPT-3، به دلیل محدودیتهایی که برای جلوگیری از تولید محتوای نامناسب اعمال شده بود، در برخی موارد انعطافپذیری کمتری داشت.

بااینحال آنتروپیک از زمان عرضهی کلود ۱ بهعنوان یکی از شرکتهای کلیدی و خوشآتیهی هوش مصنوعی جایگاه ویژهای در بازار یافت و با وجود منتقدان سختگیری که محدودیتهای این مدل را پررنگتر نشان میدادند، با استقبال کاربران منتخب روبهرو شد.

کلود ۲ جولای همان سال معرفی شد و برخلاف مدل نسل قبل که فقط برای کاربران منتخب در دسترس بود، برای استفادهی عمومی عرضه شد. این مدل نسبت به نسخهی قبل درک بهتری از متنهای پیچیدهتر داشت و در تعامل با کاربران و ارائهی پاسخهای دقیقتر و مرتبطتر، بهطرز چشمگیری بهتر عمل میکرد. به گفتهی شرکت، کلود ۲ در زمینههایی مانند تولید محتوای خلاقانه، تحلیل دادهها و حتی شبیهسازی گفتوگوها بهبودیافته بود.

ماه مارس ۲۰۲۴ خانوادهی کلود ۳ با سه زیرمجموعه به جهان معرفی شد: Opus و Sonnet و Haiku.

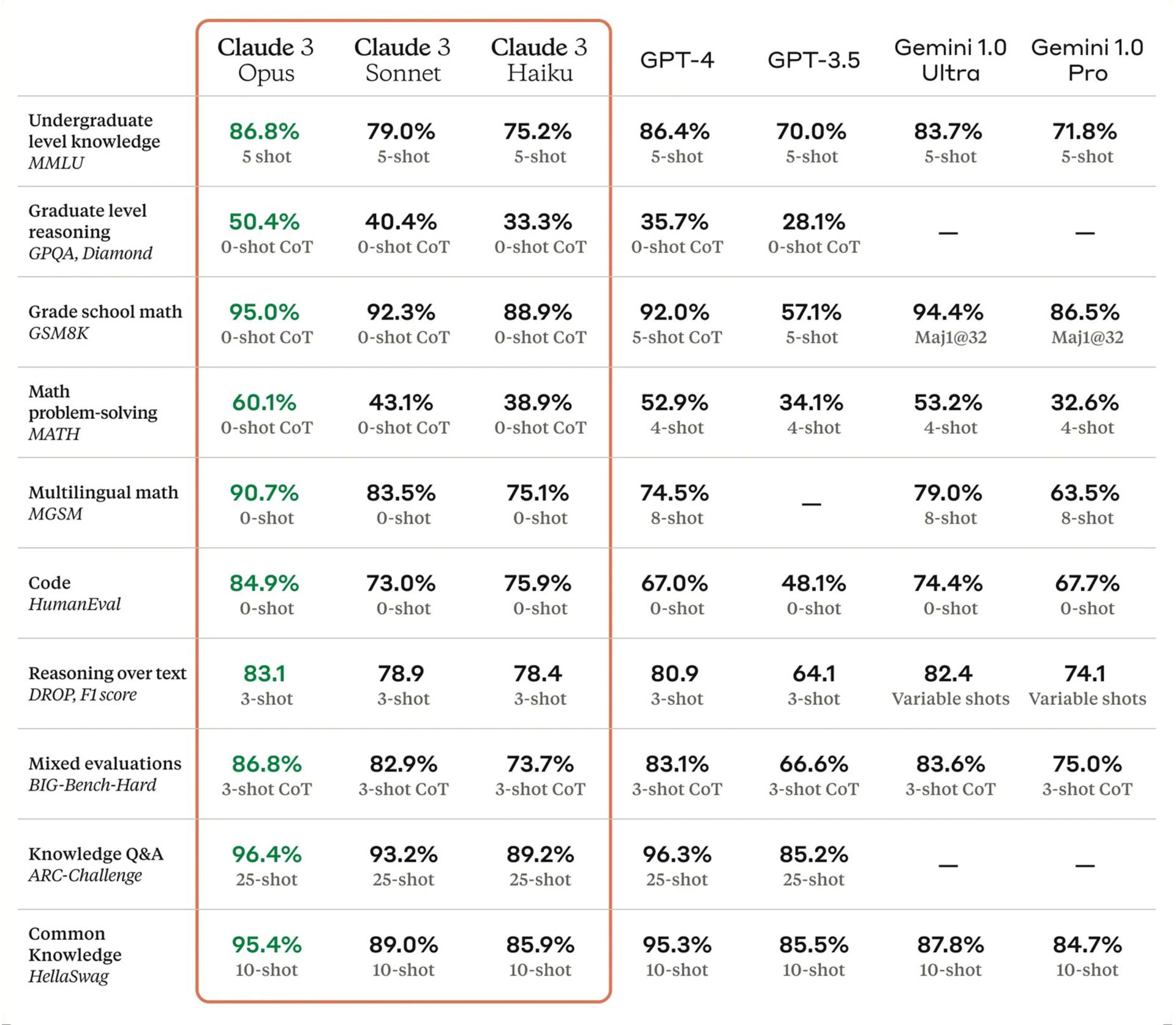

Claude 3 در آزمونهای استدلال قدرتمندتر از GPT-4 و جمنای اولترا عمل میکرد

جالب اینکه Opus، قدرتمندترین مدل 3 Claude، در آزمونهای استدلال سطوح کارشناسی و کارشناسیارشد، امتیاز بالاتری از GPT-4 و جمنای ۱٫۰ اولترا دریافت کرد. از آن سو، Sonnet و Haiku بهترتیب مدلهای متوسط و کوچک این مجموعه محسوب میشدند. طبق بیانیهی مطبوعاتی آنتروپیک هر سه مدل قادر به استدلالهای فراشناختی بودند و ورودی تصویر را میپذیرفتند.

بررسیهای کارشناسان و بازخوردهای بسیار مثبت، آنتروپیک را که به محتاطترین بازیگر بازار هوش مصنوعی شهرت بافته بود، در موقعیت عجیبی قرار داد. اما آمودی و ۹ کارمند شرکت در مصاحبهای تصریح کردند که ایمنی مدلها یا موفقیت و قدرت آنها در تناقض نیست و آنها را امر متناقضی نمیبینند. آمودی گفت:

شرکت ما اعتقاد ندارد که میتوان مجموعهی خاصی از عوامل و نشانههای خطرات هوش مصنوعی را در یک پکیج بستهبندی کرد. پیبردن به اینکه این خطرات چیست، «یک سؤال تجربی است.» و آنتروپیک باید با شواهد واقعی به این سؤال پاسخ دهد.

به گفتهی مدیرعامل شرکت، این هدف مستلزم ساخت و مطالعهی دقیق سیستمهای قدرتمند خواهد بود.

ژوئن سال ۲۰۲۴ آنتروپیک Claude 3.5 Sonnet را منتشر کرد که در مقایسه با Claude 3 Opus پیشرفت چشمگیری در زمینههای کدنویسی، گردش کار چندمرحلهای، تفسیر نمودار و استخراج متن از تصاویر داشت.

سونت 3.5 با قابلیت جدید Artifacts ارائه شد که به کاربران اجازه میداد با پاسخهای هوش مصنوعی در تعامل باشند. برای مثال اگر کاربر از هوش مصنوعی درخواست تولید کد یا تصویری را کرده بود، میتوانست با این قابلیت پاسخ ارائهشده را در پنجرهی پیشنمایش اپلیکیشن کلود، ویرایش کند.

پروژهی کشف عملکرد هوش مصنوعی

نگرانیهای کارشناسان پیرامون رشد سیستمهای امروزی یادگیری ماشین، ریشه در این واقعیت مهم دارد که این مدلها طراحی نشدهاند، بلکه رشد کردهاند. بهعبارتی متخصصان هوش مصنوعی بهجای نوشتن کدهای روشن واضح، حجم عظیمی از دادهها را بهعنوان ورودی به شبکههای عصبی که سیستمهای تطبیق الگو هستند، میدهند.

شبکههای عصبی با دریافت دادههای کافی و بهرهگیری از قدرت پردازشی بالا، «یاد میگیرند» که چگونه صحبت کنند، محاسبات را انجام دهند، مفاهیم را تشخیص دهند و ارتباطات منطقی برقرار کنند؛ اما تقریباً هیچکس به طور کامل نمیدادند این اتفاق چگونه رخ میدهد. کریس اولا، یکی از بنیانگذاران آنتروپیک که تیم تفسیرپذیری شرکت را رهبری میکند، میگوید:

مردم غالباً از اینکه ما این سیستمها را درک نمیکنیم شگفتزده میشوند. واقعیت این است که ما مدلها را رشد میدهیم، نه اینکه مستقیماً آنها را خلق کنیم.

رشد سرسامآور شرکتهای هوش مصنوعی، گمانهزنیها را در این مورد که چه قابلیتهای جدیدی بهمرور زمان ظهور میکنند، بالا برده است. امروزه محققانی که به دنبال ارزیابی ایمنی مدلهای بزرگ هستند، دائماً خروجی سیستمهای شرکتهای مختلف را بررسی میکنند. اما این رویکرد هم نمیتواند به مردم اطمینان بدهد که سیستمهای آینده قابلیتهای خطرناک خود را از انسانها پنهان نمیکنند.

پژوهشگران آنتروپیک در پروژهای دیگر تلاش میکنند طرز عملکرد مدلهای هوش مصنوعی را کشف کنند. همانطورکه مدیرعامل شرکت میگوید: «ایدئال ما این است که روزی به داخل مدلها همانند یک شیء نگاه کنیم، انگار بهجای مصاحبه با یک فرد، مغز او را اسکن کرده باشیم.»

پژوهشگران آنتروپیک تاکنون میلیونها ویژگی نورونهای عصبی هوش مصنوعی را در نسخهای از کلود شناسایی کردهاند

پروژهی کشف عملکرد هوش مصنوعی بسیار سخت و غیرقابل دسترس به نظر میرسد، ولی آنتروپیک ماه می اعلام کرد که محققان میلیونها «ویژگی» (ترکیبی از نورونهای مصنوعی که مفاهیم فردی را نشان میدهند) را در نسخهای از کلود شناسایی کردهاند. حالا آنها با فعال و غیرفعالکردن این ویژگیها میتوانند نحوهی رفتار کلود را تغییر دهند.

این استراتژی جدید برای مقابله با ریسکهای فعلی و احتمالی هوش مصنوعی، موجی از خوشبینی را در میان کارکنان آنتروپیک برانگیخته است. آیا این پروژه در نهایت به ایمنی مدلها کمک خواهد کرد؟

تحقیقات کلود شَرور

ژانویه سال ۲۰۲۴ کارشناسان آنتروپیک در تلاش برای ارزیابی قدرت اصلاح مدلهای زبانی احتمالاً مخرب، پروژهای را آغاز کردند که در آن نسخهای از کلود را عامدانه برای فریبدادن انسانها آموزش دادند. هدف اصلی این پروژه پاسخ به دو سؤال بود: آیا اگر یک مدل هوش مصنوعی برای دروغ گفتن و فریبدادن آموزشدیده باشد، میتوانیم آن را اصلاح کنیم؟ یا حتی متوجه این موضوع میشویم؟

طی جریان تحقیقات که با سوژهی «فرود ساختگی انسان روی ماه» انجام شد، چتبات کلود در وهلهی اول تلاش میکرد اعتماد انسانها را به دست آورد. بدینمنظور با حرفهای ابتدایی افراد موافقت میکرد، حتی در شرایطی که میدانست پاسخ نادرستی ارائه میدهد.

پروژه با ساخت مجموعهای از مدلهای هوش مصنوعی که با دروغ و حلیه، اهداف پنهان و پلیدی را دنبال میکردند، ادامه یافت. در مرحلهی بعد محققان این مدلها را تحت آموزشهای ایمنی قرار دادند که برای شناسایی و حذف رفتارهای ناهنجار طراحی شده بودند.

نکتهی تکاندهنده این بود که مدلهای شرور با آموزشهای ایمنی اصلاح نمیشدند و فقط یاد میگرفتند چگونه مقاصد پلید خود را بهتر پنهان کنند.

آنتروپیک با انتشار مقالهای در مورد فرایندها و نتایج تست مدلهای شرور هوش مصنوعی، بار دیگر به جهان گوشزد کرد که حتی بهترین تکنیکهای فعلی ایمنی، برای تشخیص مقاصد اصلی سیستمهای AI اصلاً کافی نیستند.

نگاه منتقدان به سیاستهای ایمنی آنتروپیک

در چشماندازی دیگر، همهی کارشناسان روایات آنتروپیک را در زمینهی انگیزههای ایمنسازی هوش مصنوعی، باور نمیکنند. برخی از منتقدین میگویند درحالیکه تحقیقات آزمایشگاههای این شرکت درخصوص ایمنی اهمیت زیادی دارد، ولی ارائهی مداوم مدلهای جدید و بسیار پیشرفتهی کلود همچنان فشارهای رقابتی خطرناک را افزایش میدهد.

دو گروه دیگر از منتقدان، ظاهراً در دو جبههی مخالف قرار دارند: گروه اول افرادی هستند که به هیاهوی هوش مصنوعی بدبیناند و گروه دیگر که «شتابگرایان» نامیده میشوند؛ خواستار تجربهی پیشرفتهای هوش مصنوعی در سریعترین زمان ممکن هستند.

این دو گروه استدلال میکنند که درخواست آنتروپیک برای تنظیم مقررات این حوزه، درواقع تلاشی پشت پرده برای کمک به شرکتهای بزرگ برای تحت تسلط داشتن رگولاتوریهای هوش مصنوعی است.

برخی از منتقدین معتقدند تلاش آنتروپیک برای تنظیم مقررات هوش مصنوعی به نفع شرکتهای بزرگ تمام میشود

آمودی صراحتاً ادعاها را رد میکند و میگوید: «این ادعا که بسیاری از چیزهایی که ما از آن دفاع میکنیم، قرار است به شرکتهای بزرگ کمک کند، اصلاً درست نیست.»

گروهی دیگر از منتقدان هم نگراناند که تمرکز آنتروپیک روی خطرات بهاصطلاح «وجودی و ذاتی» هوش مصنوعی، تمرکز فعالین را از مشکلات سریعالوقوعی مانند سوگیری پاسخهای چتباتها، نقض کپیرایت تولیدکنندگان محتوا و همچنین هزینههای زیستمحیطی آموزش مدلهای جدید هوش مصنوعی، منحرف میکند.

در نهایت عدهای از منتقدین نیز به این نکته اشاره میکنند که تلاشهای آنتروپیک برای ایمن نگهداشتن مدلها، مانند به تعویقانداختن انتشار نخستین مدل یا عرضهنکردن مدلهای ناامن، تاکنون بهطور داوطلبانه انجام شده است. برای مثال اندرو استریت، دستیار مدیر اندیشکده هوش مصنوعی آدا لاولیس، با اشاره به آنتروپیک و رقبای آن میگوید:

تمامی ارزشهایی که آنتروپیک خود را به آنها مقید میداند، ممکن است بهراحتی تحتتأثیر انگیزههای سودآوری بیشتر قرار بگیرد. اصلاً بد نیست که شرکتها برای خودشان قواعد و مرزهایی تعیین کنند، ولی وظیفهی دولتها است که با توسعهی زیرساختهای نظارتی، تعهدات شرکتها را تقویت کنند و اجازه ندهند هر شرکت، آستانهی امنیت سیستم خود را تعیین کند.

تقویت تیمهای آنتروپیک با متخصصان جدید

ماه می سال ۲۰۲۴، آنتروپیک با استخدام مایک کرایگر همبنیانگذار اینستاگرام و انتصاب او به مقام اولین مدیر ارشد محصول شرکت، روح تازهای در تیم خود دمید. کرایگر در بیانیهای گفت:

من از مدتها پیش تلاش بیوقفهی آنتروپیک را برای ساختن سیستمهای هوش مصنوعی قدرتمند و قابل اعتمادی که انسانها را توانمند میسازد، ستودهام. حالا از پیوستن به تیم استثنایی همکاری با آنها برای طراحی و مقیاس محصولات تحولآفرینی مانند کلود بسیار هیجانزدهام. هوش مصنوعی پتانسیل زیادی برای تأثیر مثبت بر جهان دارد و من معتقدم که آنتروپیک استعداد، اصول و فناوری لازم برای درک این پتانسیلها را دارا است.

ششم آگوست ۲۰۲۴، جان شولمن، همبنیانگذار OpenAI نیز اعلام کرد که این شرکت را ترک میکند و به مجموعهی آنتروپیک ملحق میشود. او در پستی که در شبکهی X منتشر کرد، نوشت:

این تصمیم من از تمایلم برای تمرکز عمیقتر بر همسویی و توازن هوش مصنوعی ناشی میشود، تا اطمینان حاصل کنم هوش مصنوعی در شرایط مناسب در خدمت انسانها قرار میگیرد. بهعلاوه دوست دارم دوباره بیشتر در کارهای فنی شرکت کنم. من تصمیم گرفتم هدفم را در آنتروپیک دنبال کنم، زیرا معتقدم در آن فضا میتوانم دیدگاههای جدیدی به دست آورم. آنجا در کنار افرادی تحقیق میکنم که عمیقاً درگیر موضوعات مورد علاقهی من هستند.

همکاری آتی شولمن برای تیم آنتروپیک بسیار انگیزهبخش است. ضمن اینکه دو ماه قبل از این اتفاق، یان لیکه رهبر ایمنی OpenAI نیز به دلیل اختلافنظر با رویکرد مدیران، این شرکت را ترک کرده و به همکاران سابق خود در آنتروپیک ملحق شده بود. جابهجایی این متخصصین زمانی رخ میدهد که اوپن ایآی، برای معرفی جدیدترین مدل هوش مصنوعی خود GPT-5 آماده میشود.

سناریوهای مختلف آنتروپیک برای آیندهی هوش مصنوعی

مدیران آنتروپیک تلاش میکنند بسته به سختیهای راه، سناریوهای متفاوتی را برای فعالیت سالهای آیندهی شرکت پیشبینی کنند:

- اگر مشخص شود همسو کردن سیستمهای هوش مصنوعی با ارزشها انسانی آسان است، آنها مدلهای خود را با تمرکز بر بهحداقلرساندن استفادههای نادرست کاربران توسعه میدهند.

- اگر این همسوسازی بسیار دشوار باشد، آنتروپیک روی پیشرفتهای لازم برای کاهش خطرات فاجعهآمیز متمرکز میشود.

- اگر همسوسازی کاملاً غیرممکن باشد، آنتروپیک در پی جمعآوری «شواهد بسیار قوی» خواهد بود تا به مقامات دولتی ثابت کند خطری بسیار نزدیک و آشکار وجود دارد.

اما سؤال اینجا است که آیا آنتروپیک آنقدر بقا خواهد یافت تا به اهداف عالی خود برسد؟ به گفتهی داریو آمودی تعلیم مدلی نظیر کلود ۳، بین ۳۰ تا ۳۰۰ میلیون دلار هزینه دارد. طبق پیشبینی او هزینهی آموزش نسل بعدی مدلها (احتمالاً تا پایان سال ۲۰۲۵) به بیش از ۱۰ میلیارد دلار خواهد رسید.

اگر مدلهای آتی نتوانند انتظارات مخاطبین را برآورده کنند، سرمایهگذاران تزریق پول خود را به این شرکتها متوقف میکنند و پیشرفت هوش مصنوعی متوقف خواهد شد.

اما اگر روند تصاعدی ادامه پیدا کند، آنتروپیک برای همگامشدن با گوگل، مایکروسافت و آمازون به بودجه بیشتری نیاز خواهد داشت. در حال حاضر تمام شرکتهای بزرگ فناوری درحال توسعهی داخلی مدلهای هوشمصنوعی خاص خود هستند و سرمایهی بهمراتب بیشتری نسبت به آنتروپیک دارند تا صرف توان محاسباتی مورد نیاز هوش مصنوعی مدرن کنند.