اپل از مجموعه قابلیتهای امنیتی جلوگیری از آسیب کودکان رونمایی کرد

اخیراً در فضای مجازی بازار شایعات در رابطه با ویژگیهای امنیتی جدید اپل بهمنظور تشخیص آزار و اذیت کودکان بسیار داغ بوده است و گفته میشود غول دنیای فناوری در حال توسعه ابزارهای بسیار پیشرفتهای است که میتواند با شناسایی ترافیک داده آیکلاد، پورنوگرافی کودکان را تشخیص و به مراجع قانونی اطلاع بدهد. اپل روز گذشته بهطور رسمی از مجموعهای ویژگی امنیتی رونمایی کرد؛ ویژگیهایی که ظاهراً بار دیگر سیاستهای این شرکت در قبال امنیت و حریم خصوصی کاربران را در کانون توجهات قرار داده است.

پنجشنبه گذشته، اپل ویژگیهای جدید ایمنی کودکان را در سه حوزه معرفی کرد که از قرار معلوم، به محافظت از افراد زیر ۱۷ سال در برابر مجرمان، متجاوزان و محدود کردن انتشار مواد سوءاستفاده جنسی از کودکان (CSAM) کمک میکند. اپل در این باره میگوید: «هدف ما ایجاد فناوریهایی است که به افراد قدرت میبخشد، زندگی آنها را غنی میکند و در عین حال آنها را گزند خطرات ایمن نگه میدارد.»

طبق اعلام اپل، این شرکت برنامه پیامرسانش را به ابزار امنیتی جدیدی مجهز میکند که به والدین اجازه میدهد در مورد نحوه ارتباط آنلاین فرزندانشان بیشتر آگاه شوند. اپل همچنین از سیستم جدیدی استفاده میکند که از تکنیکهای رمزنگاری برای تشخیص مجموعههای CSAM ذخیرهشده در تصاویر مبتنی بر آیکلاد و شناسایی مجرمان بهره میگیرد. همچنین در آیندهای نزدیک، ابزارهای امنیتی جدیدی به جستوجوی دستیار هوشمند سیری اضافه خواهد شد.

جان کلارک، مدیرعامل و رئیس مرکز ملی کودکان مفقود و استثمارشده، در پشتیبانی از قابلیتهای جدید کوپرتینوییها میگویند حمایت گسترده اپل از کودکان، تحولی اساسی و تغییردهنده ایجاد خواهد کرد. وی خاطرنشان میکند که با توجه به جامعه گسترده کاربران محصولات اپل، اقدامات امنیتی مذکور برای کودکانی که در فضای اینترنتی و آنلاین فریب میخورند و تصاویر ناراحتکننده آنها در مطالب مربوط به سوءاستفاده جنسی منتشر میشود، میتواند بسیار حائز اهمیت و حتی نجاتدهنده باشد. کلارک در ادامه افزود:

[ما] در مرکز ملی کودکان مفقود و استثمارشده میدانیم که مبارزه با این جنایات دلخراش در صورتی امکانپذیر است که قاطعانه در تعهد خود به حمایت از کودکان پایبند باشیم. درواقع فقط میتوانیم این کار را انجام بدهیم؛ زیرا در سوی دیگر ماجرا شرکای فناوری نظیر اپل قرار دارند که میتوانند با اقداماتشان در بهبود شرایط بسیار تأثیرگذار باشند. واقعیت این است که حریم خصوصی و حفاظت از کودکان میتوانند همزمان وجود داشته باشند. ما از [ویژگیهای امنیتی] اپل استقبال میکنیم و مشتاقانه منتظر همکاری با هم هستیم تا این جهان را به مکانی امن برای کودکان تبدیل کنیم.

اپل میگوید تمامی ویژگیهای جدید منطبق با استانداردهای حریم خصوصی این شرکت بهینه شدهاند و اطمینان حاصل میکنند که میتواند اطلاعات مربوط به فعالیت مجرمانه را بدون تهدید اطلاعات خصوصی کاربران مطیع قانون به مقامات مربوطه ارائه بدهد. ویژگیهای امنیتی مذکور همسو با انتشار بهروزرسانی سیستمعاملهای اپل در پاییز سال جاری میلادی به نمایش درخواهند آمد. در حقیقت شناسایی CSAM در حسابهای آیکلاد فوتوز مهمترین بخشی محسوب میشود که تمرکز اصلی اپل به ارائه آن معطوف شده است.

در توصیف این قابلیت آمده است که اگر اپل مجموعه تصاویر CSAM ذخیرهشده در حساب آیکلاد مجرمان را تشخیص بدهد، آن حساب را نشانهگذاری میکند و اطلاعاتی در اختیار NCMEC قرار میدهد که بهعنوان مرکز گزارش مواد سوءاستفاده از کودکان کار و با سازمانهای اجرای قانون در سراسر ایالات متحده همکاری میکند. نکته حائز اهمیت این است که اپل تصاویر را اسکن نمیکند و در عوض، از اطلاعات روی دستگاه برای مطابقت CSAM با پایگاه داده شناختهشده از هشهای ارائهشده توسط NCMEC و سایر سازمانهای ایمنی کودک استفاده میکند. این پایگاه داده به مجموعهای از هشهای ناخوانا تبدیل میشود که بهطور ایمن در دستگاه کاربر ذخیره میشوند.

روش واقعی تشخیص CSAM در آیکلاد فوتوز پیچیده است و از تکنیکهای رمزنگاری در هر مرحله برای اطمینان از صحت و حفظ حریم خصوصی برای کاربران عادی استفاده میکند. به گفتهی اپل، حساب نشانهگذاریشده پس از فرایند بازبینی دستی غیر فعال میشود تا از خاطی بودن فرد صاحب حساب اطمینان حاصل شود. پس از غیر فعال شدن حساب، اپل پیامی به NCMEC ارسال میکند. اگر کاربران احساس کنند بهاشتباه هدف قرار گرفتهاند، میتوانند در مورد فسخ حساب تجدید نظر کنند.

در مستندات ارائهشده توسط اپل چندین بار تأکید شده است که این ویژگی فقط CSAM ذخیرهشده در بخش فوتوز در سرویس ابری آیکلاد را تشخیص میدهد و مورد عکسهایی که کاملاً روی دستگاه ذخیره میشوند اعمال نمیشود؛ به عبارت دیگر، ابزار امنیتی یادشده فقط کاربرانی را به مراجع ذیصلاح گزارش میدهد که مجموعهای از تصاویر شناختهشده CSAM را در سرویس ابری آیکلاد ذخیره کرده باشند. علاوه بر این، اپل ادعا میکند که نرخ خطا در سیستم کمتر از یک در یک تریلیون حساب در سال است!

سیستم تشخیص CSAM فقط برای شروع به حسابهای آیکلاد مستقر در ایالات متحده آمریکا اعمال میشود؛ اما اپل میگوید احتمالاً در آینده سیستم را در مقیاس وسیعتری در سایر نقاط جهان به کار خواهد گرفت.

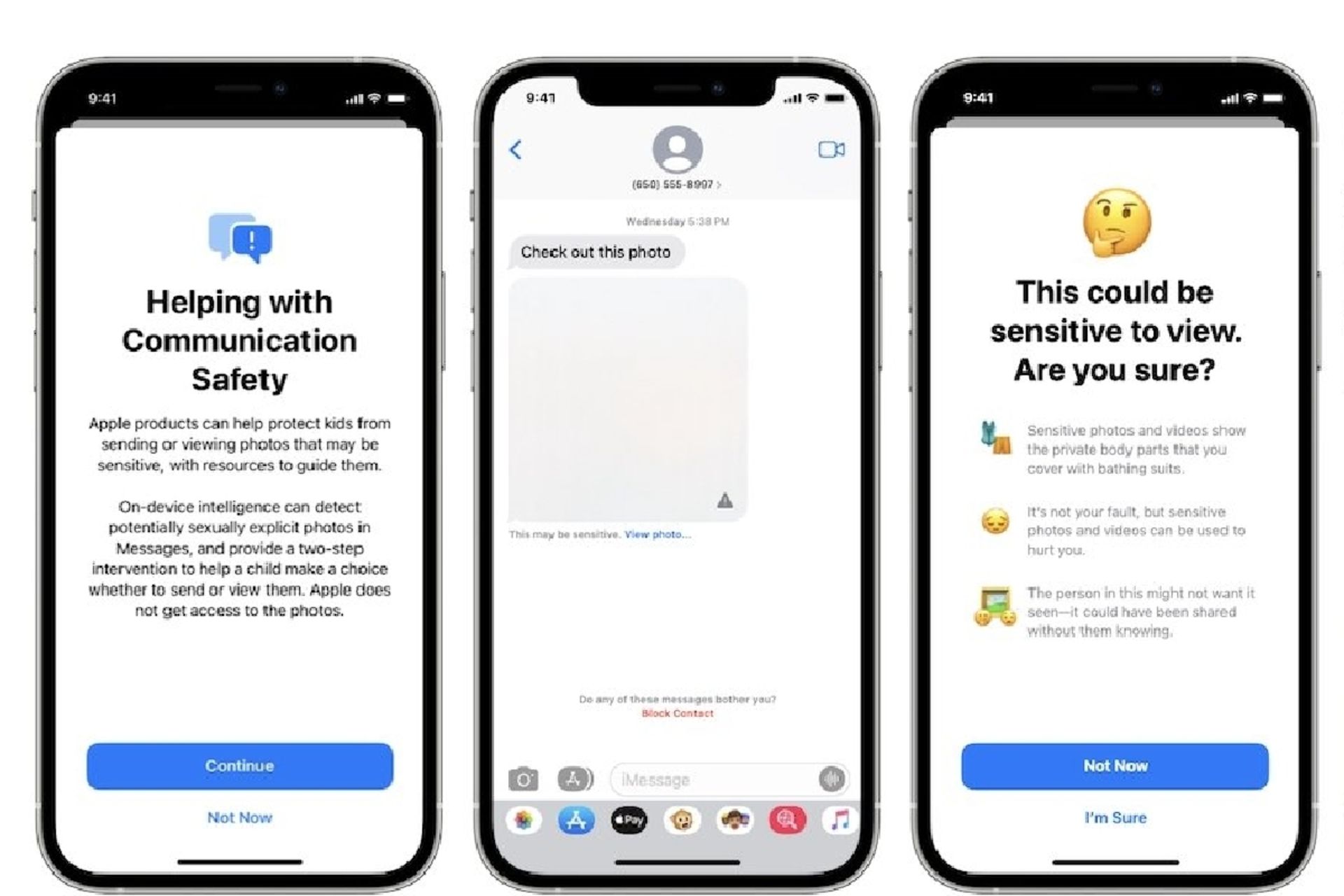

ایمنی ارتباطات

یکی از بهروزرسانیها بر افزایش ایمنی کودکان در برقراری ارتباط آنلاین پیامرسان آیمسیج اپل متمرکز است. برای مثال، برنامه آیمسیج اکنون هنگام دریافت یا ارسال عکسهای جنسی هشدارها را به کودکان و والدین نشان میدهد. اگر کودک زیر ۱۷ سال یک تصویر حساس دریافت کند، بهطور خودکار تار میشود و منابع مفیدی برای اطلاعرسانی از مضر بودن این تصاویر در اختیار کودک قرار میگیرد. اپل همچنین مکانیزمی در نظر گرفته است که به کودکان زیر ۱۳ سال میگوید در صورت مشاهده پیام برای والدین آنها ارسال میشود. هنگام باز کردن این تصاویر، کودکان بین ۱۳ تا ۱۷ سال مشمول اطلاعرسانی والدین نمیشوند و نمیتوان ایمنی ارتباطات را در حسابهای مورد استفاده بزرگسالان بالای ۱۸ سال فعال کرد.

این سیستم از یادگیری ماشین دستگاه برای تجزیه و تحلیل تصاویر و تعیین صراحت جنسی استفاده میکند و بهطور خاص طراحی شده است تا اپل به کپی تصویر دسترسی نداشته باشد و آنها را دریافت نکند.

بهروزرسانی سیری و بخش جستوجو

علاوه بر ویژگیهای ایمنی آیمسیج، اپل در حال گسترش ابزارها و منابعی است که در سیری و بخش جستوجو ارائه میدهد. کاربران آیفون و آیپد قادر خواهند بود از سیری بپرسند که چگونه میتوانند موارد CSAM را گزارش کنند. سپس سیری منابع و راهنماییهای مناسب را ارائه میدهد. بهروزرسانی سیری و بخش جستوجو منجر میشود در صورت انجام جستوجوی مرتبط با CSAM، این نهاد بهسرعت وارد عمل شود. غول دنیای فناوری خاطرنشان میکند که این مداخلات به کاربران توضیح میدهد که علاقه به این موضوع مضر و مشکلساز است و منابع مفیدی از شرکا برای کمک در این زمینه ارائه میدهد.

حفظ حریم خصوصی کاربران

یکی از ارکان مهم سیاستهای اپل در سالیان اخیر حفظ حریم خصوصی بوده و تاکنون اقدامات چالشبرانگیزی در این حوزه انجام داده است. همانطور که در بخشهای پیشین اشاره شد، ابزارهای امنیتی جدید اپل مزیتهای بسیاری برای محافظت از کودکان در برابر سوءاستفادهی احتمالی ایجاد میکند و تاکنون برخی از سازمانها حمایت کامل خود را از این ویژگیها اعلام کردهاند؛ اما معرفی یک سیستم بهمنظور ارائه اطلاعات به مجریان قانون برخی از کارشناسان امنیتی را نگران کرده است. این نوع ابزار میتواند برای پیدا کردن پورنوگرافی کودکان در گوشیهای هوشمند افراد مفید باشد؛ اما تصور کنید که این ویژگیها در دستان یک حکومت اقتدارگرا چه تبعاتی به همراه دارد!

اپل معتقد است که نظارت و سوءاستفاده از سیستمها در هنگام توسعه آنها نگرانی اصلی بوده است. کوپرتینوییها میگویند هر ویژگی را برای اطمینان از حفظ حریم خصوصی هنگام مقابله با CSAM یا سوءاستفاده از کودکان به صورت آنلاین طراحی کردهاند. بهعنوان مثال، گفته میشود سیستم تشخیص CSAM از ابتدا برای تشخیص CSAM طراحی شده است و ظاهراً شامل مکانیزمهایی برای تجزیهوتحلیل یا تشخیص هر نوع عکس دیگر نیست و فقط مجموعه CSAM را در یک آستانه خاص تشخیص میدهد.

اپل استدلال میکند که این سیستم دریچهای برای نظارت باز نمیکند و هیچ کاری برای تضعیف رمزگذاری آن انجام نمیدهد. این شرکت تأکید میکند که سیستم تشخیص CSAM فقط عکسهایی که رمزگذاری سرتاسری ندارند، شناسایی و مورد بررسی قرار میدهد. با وجود گفتههای اپل، کارشناسان امنیتی هنوز نگران عواقب آن هستند. متیو گرین، استاد رمزنگاری در دانشگاه جان هاپکینز، خاطرنشان میکند که هشها بر اساس پایگاه دادهای هستند که کاربران نمیتوانند آن را مرور کنند؛ بنابراین، امکان سوءاستفاده از آنها وجود دارد. گرین در ادامه میگوید:

این ایده که اپل یک شرکت حافظ حریم خصوصی است، توجه مطبوعات و رسانههای زیادی را جلب کرده است؛ اما مهم است به خاطر داشته باشید که این همان شرکتی است که به دلیل فشارهای FBI پشتیبانگیری آیکلاد کاربرانش را رمزگذاری نمیکند.

راس اندرسون، استاد مهندسی امنیت در دانشگاه کمبریج، در مصاحبه با فایننشال تایمز این سیستم را «ایدهای کاملاً وحشتناک» توصیف کرده. وی معتقد است که این قابلیت میتواند منجر به نظارت مستمر به فعالیت گوشیهای هوشمند توسط برخی سازمانها شود. گروه حقوق دیجیتال بنیاد مرزهای الکترونیکی نیز بر این باور است که ویژگیهای مذکور راه را برای سوءاستفادهی گستردهتر باز میکند. بنیاد یادشده با انتشار پستی در وبلاگ خود میگوید:

تنها چیزی که اپل برای گسترش درِ پشتی در دست ساختش نیاز خواهد داشت، توسعه پارامترهای یادگیری ماشین برای جستوجوی انواع دیگر محتوا یا تغییر در اولویتبندی برای اسکن سایر حسابها است. این یک مشکل کوچک نیست؛ بلکه یک سیستم کاملاً ساخته شده که فقط منتظر فشار خارجی برای ایجاد تغییرات است.

با توجه به آنچه گفته شد، به نظر میرسد ویژگیهای امنیتی جدید اپل میتوانند بسیار مفید باشند؛ اما به برخی سوءاستفادههای حریمی خصوصی نیز منجر شوند. البته هنوز اطلاعات زیادی در رابطه با سیاستهای اپل برای مقابله با این نگرانیها منتشر نشده است؛ اما این احتمال وجود دارد که غول دنیای فناوری با اتخاذ تمهیداتی، این ویژگیها را در یک چهارچوب امن و شفاف ارائه بدهد تا نظر سازمانهای حفظ حریم خصوصی را به خود جلب کند.

برای مطالعهی تمام مقالات مرتبط با اپل به این صفحه مراجعه کنید.

نظرات