سریعترین ابرکامپیوتر جهان، رکورد جدیدی در هوش مصنوعی ثبت کرد

در ساحل غربی ایالات متحده، غولهای فناوری تلاش میکنند تا با استفاده از منابع فراوان خود، هوش مصنوعی را هرچه بیشتر هوشمندتر کنند. گوگل و فیسبوک، با استفاده از میلیاردها عکس و هزاران پردازندهی پرقدرت، تلاشهایی در این زمینه داشتند و به موفقیتهایی هم رسیدند. بههرحال باوجود تمام تلاشهای غولهای سیلیکونولی، سال گذشته دستاورد مهم حوزهی هوش مصنوعی در شرق آمریکا و منطقهی تنسی و در یک پروژهی دولتی رقم خورد.

پروژهای که سال گذشته توانست رکورد جدیدی در حوزهی هوش مصنوعی ثبت کند، از قویترین ابرکامپیوتر جهان یعنی Summit در آزمایشگاه Oak Ridge استفاده میکرد. این ابرکامپیوتر در ماه ژوئن سال گذشتهی میلادی (خرداد) توانست رکورد جدید در علم هوش مصنوعی را بهنام آمریکاییها ثبت کند و پس از ۵ سال، رتبهی اول این رقابت را از چین برباید.

ابرکامپیوتر دولت آمریکا، در یک پروژهی بررسی تغییرات اقلیمی و آبوهوایی بهکار گرفته شد. این ابرکامپیوتر توانست سطوح جدیدی از یادگیری ماشین را پیادهسازی کند که سریعتر از هر نمونهی قبلی بود.

Summit، ابرکامپیوتر سریع آمریکاییها با ابعادی حدود ۲ زمین تنیس است. این غول پردازشی برای پروژهی بررسی تغییرات اقلیمی، از ۲۷ هزار پردازندهی گرافیکی استفاده کرد. پردازندههای گرافیکی، برای پیادهسازی هرچه بهتر الگوریتمهای یادگیری ماشین، فناوری پیشگام صنعت هوش مصنوعی، استفاده شدند. سرعت سامیت در پردازشهای مورد نیاز برای پروژهی فوق، چندین میلیارد عملیات در ثانیه بود که در اصطلاحات ابرکامپیوتری با اکزافلاپ شناخته میشود.

آمریکا پس از ۵ سال جایگاه چین را در سرعت هوش مصنوعی تصاحب کرد

پرابات (Prabhat) یکی از دانشمندان هوش مصنوعی آمریکایی است که یک تیم تحقیقاتی را در آزمایشگاه ملی لارنس برکلی آن کشور رهبری میکند. گروه او با دانشمندان حاضر در اوک ریج و درگیر در پروژهی سامیت همکاری میکرد. پرابات اعتقاد دارد یادگیری عمیق تاکنون به چنین سطحی از کارایی و سرعت نرسیده بود.

نکتهی خاص پروژهی رکوردشکن آمریکاییها، آن بود که از قویترین ابرکامپیوتر جهان، برای حل بزرگترین مشکل جهان یعنی تغییرات اقلیمی استفاده میکرد. شرکتهای فناوری، از نوآوریهای یادگیری عمیق و هوش مصنوعی خود برای تشخیص دادن چهرهها یا علائم راهنمایی و رانندگی استفاده میکنند. درحالیکه محققان دولتی آمریکا، از آن برای پیشبینی شرایط آبوهوایی و تغییرات آتی آن استفاده کردند.

خروجیهای فراوانی که از شبیهسازیهای اقلیمی بهدست میآیند، دادههای تغذیهای پروژهی هوش مصنوعی ابرکامپیوتر سامیت بودند. این دادهها، نتایجی با ارزش از تغییرات آتی اتمسفر زمین عرضه میکردند که بهصورت پیشبینیهای ۳ ساعته از آیندهی یک قرن اتمسفر به سیستم ارائه شد. با تحلیل آن دادهها، میتوان الگوهای آبوهوایی را برای مناطق مختلف پیشبینیکرد. البته مشخص نیست که برای پیادهسازی همین پروژه، چهمقدار انرژی مصرف شده یا چقدر کربن به اتمسفر زمین اضافه شده است.

این پروژه هم مرزهای هوش مصنوعی و هم پیشبینی آبوهوا را جابهجا کرد

پروژهی سامیت، هم برای آیندهی علم آبوهوا و هم هوش مصنوعی، دستاوردهای متنوعی دارد. این پروژه، نشاندهندهی ظرفیت علمی استفاده از یادگیری عمیق در ابرکامپیوترها است. ابرکامپیوترها، قبلا برای مواردی همچون شبیهسازی فرایندهای فیزیکی و شیمیایی مانند انفجارهای هستهای، یا تحقیقات پیرامون سیاهچالهها و کشف مواد جدید، استفاده میشدند. بهعلاوه، پروژهی مذکور نشان میدهد که یادگیری ماشین، چه فواید زیادی از قدرت ابرکامپیوترها کسب خواهد کرد. درنهایت، میتوان نتیجه گرفت که آیندهی روشنی از ترکیب این دو فناوری ساخته میشود.

گوگل نیز در پروژهی ملی ابرکامپیوتر سامیت شرکت داشته است. آنها نرمافزار یادگیری ماشین متنباز خود با نام TensorFlow را در اختیار ماشین سامیت گذاشتند تا برای فرایندهای تحقیقاتی از آن استفاده شود. راجات مونگا، یکی از مهندسان ارشد گوگل دربارهی دستاورد فوق میگوید خودشان نیز انتظار چنین دستاوردهای بزرگی را نداشتند و تنها پس از پیادهسازی پروژه به ابعاد عظیم آن پی بردند.

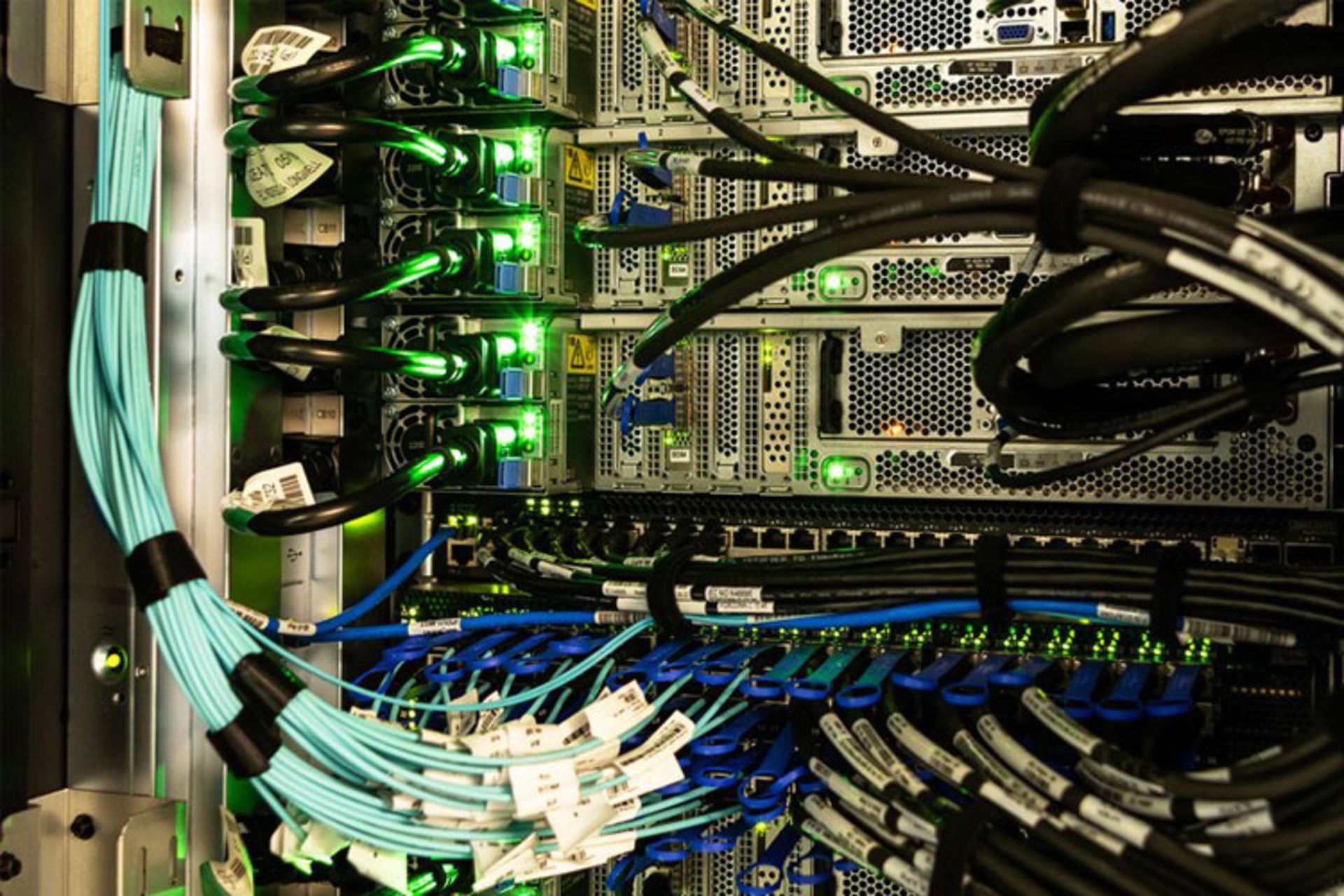

اکثر پروژههایی که با هدف مقیاسدهی به یادگیری عمیق انجام شدهاند، در مراکز دادهی شرکتهای اینترنتی شکل گرفتند. در آن فضاها، سرورها با همکاری یکدیگر مسائل پروژه را به قسمتهای کوچکتر تقسیم کرده و آنها را حل میکنند. در آن ساختارها، سرورها اتصالی موازی با یکدیگر دارند و به کامپیوتر عظیم مرکزی، وابسته نیستند.

ابرکامپیوترهایی همچون سامیت، ساختاری متفاوت با مراکز داده و خوشههای سرورها در شرکتهای اینترنتی دارند. آنها ارتباطاتی با سرعت بالا دارند که هزاران پردازندهی درگیر را به یک سیستم مرکزی متصل میکند و آن سیستم، درنهایت بهصورت یک کامپیوتر مستقل کار خود را انجام میدهد. تا چندی پیش، استفاده از چنین معماری برای پیادهسازی یادگیری ماشین، آنچنان مرسوم نبود و نمونههای اندکی از آن مشاهده میشد.

مونگا در ادامهی صحبتهایش دربارهی پروژه میگوید پیادهسازی تنسورفلو در ابرکامپیوتر سامیت، تلاشهای داخلی گوگل برای گسترش سیستمهای هوش مصنوعی داخلیاش را نیز بهخوبی نشان میدهد. مهندسان انویدیا نیز در این پروژه همکاری داشتند. آنها از اتصال و کارکرد هزاران پردازندهی گرافیکی شرکت در پروژهی ابرکامپیوتر، اطمینان حاصل کردند.

تلاش برای پیدا کردن راههای بهمنظور استفاده از قدرت پردازشی بیشتر در الگوریتمهای یادگیری عمیق، در سالهای اخیر بخش مهمی از تلاشهای صنعت را به خود اختصاص داده است. فناوری یادگیری عمیق، همان فناوری است که به Siri امکان میدهد صدای شما را شناسایی کند. در کاربردی دیگر، یادگیری عمیق به کمک ماشینهای Waymo میآید تا علائم راهنمایی و رانندگی را مشاهده کرده و تشخیص دهند. انفجار کاربردهای این فناوری، در سال ۲۰۱۲ و زمانی رخ داد که دانشمندان، توانستند از پردازندههای گرافیکی همچون محصولات انویدیا، برای افزایش کارایی آن استفاده کنند.

مؤسسهی تحقیقاتی OpenAI یکی از سازمانهایی است که در سنفرانسیسکو قرار داشته و نام ایلان ماسک را در جایگاه بنیانگذاران یدک میکشد. آنها در ماه می سال گذشته، تحلیلی از تحقیقات پیرامون یادگیری عمیق منتشر کردند. طبق تحلیلهای منتشرشده، از سال ۲۰۱۲، قدرت پردازشی استفادهشده در بزرگترین پروژههای عمومی یادگیری ماشین در جهان، هر ۳.۴۳ ماه، ۲ برابر شده است. چنین تحلیلی، بهمعنای ۱۱ برابر شدن قدرت پردازشی مورد استفاده، در هر سال است.

گوگل و انویدیا، زیرساختهای نرمافزاری و سختافزاری پروژه را آماده کردند

افزایش قدرت پردازشی در پروژههای یادگیری ماشین و هوش مصنوعی، بهمعنای افزایش توانایی محصولات آنها خواهد بود. همین قدرت پردازشی، به رباتهایی همچون محصول شرکت مادر گوگل (آلفابت) امکان داد تا غولهای بازیهای فکری همچون مسابقات بازیهای تختهای و بازیهای استراتژی ویدئویی را شکست دهند. بهعلاوه، دقت سرویس ترجمهی گوگل نیز با استفاده از همین تواناییهای یادگیری عمیق افزایش یافت.

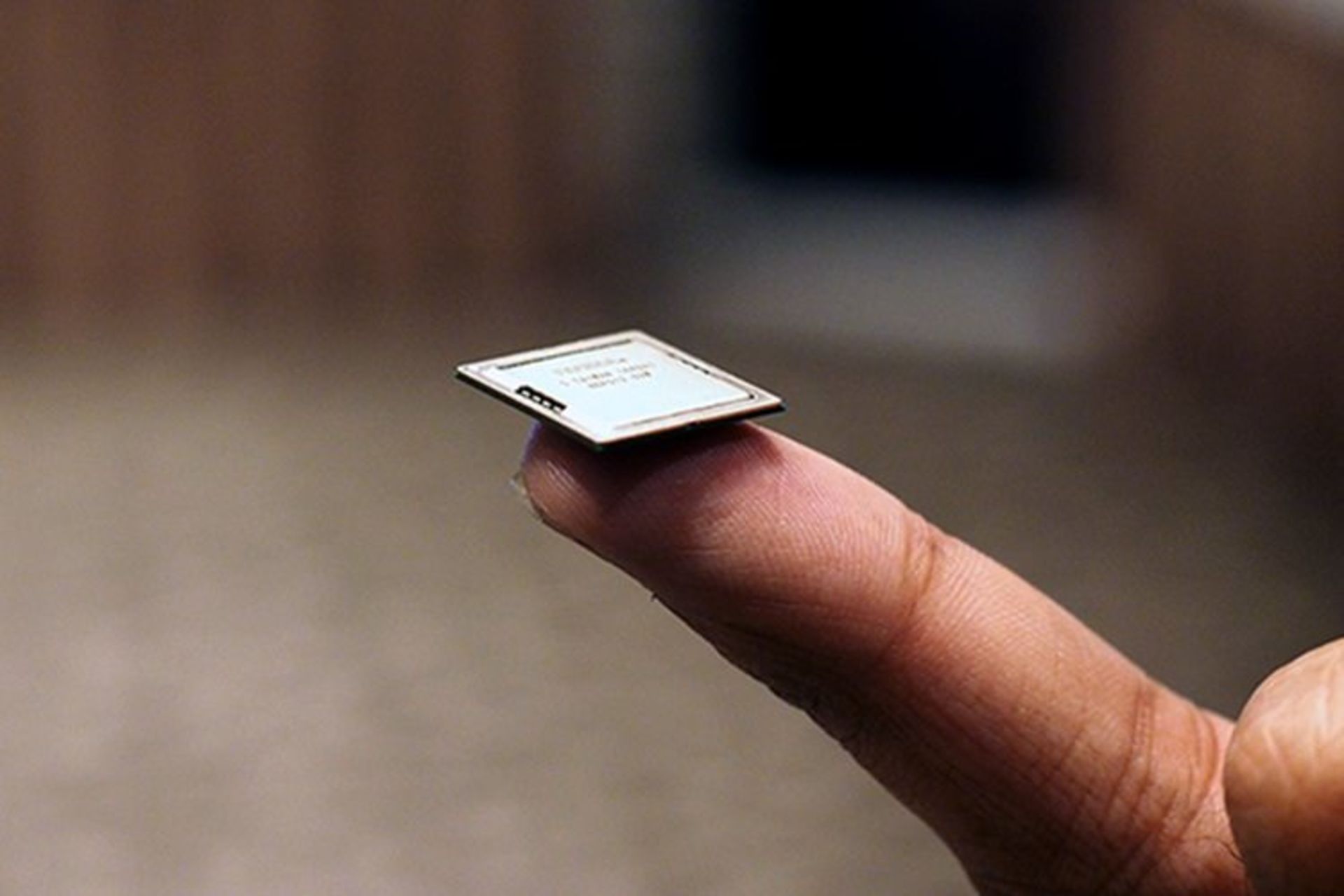

گوگل و دیگر غولهای دنیای فناوری، اکنون به فکر توسعهی تراشههای جدید هستند تا قابلیتهای فناوری یادگیری عمیق را بیشازپیش توسعه دهند. تراشههای اختصاصی یادگیری عمیق، عموما با اصطلاح TPU شناخته میشوند. گوگل ادعا میکند خوشههایی که از هزار عدد تراشههای اختصاصی این شرکت برای فرایندهای یادگیری عمیق استفاده کنند، توانایی ارائهی ۱۰۰ پتافلاپ قدرت پردازشی دارند. چنین عددی، حدودا یکدهم قدرت پردازشی بهکارگرفتهشده در ابرکامپیوتر سامیت است.

پروژهی سامیت، کاربرد بالایی در علم اقلیمشناسی داشت. نتایج پروژه نشان میدهد که چگونه یک هوش مصنوعی با قدرت پردازشی بسیار بالا، میتواند درک ما از تغییرات الگوهای آتی آبوهوایی را بهبود ببخشد. وقتی دانشمندان پیشبینیهایی برای یک قرن آیندهی آبوهوا ارائه دهند، خواندن پیشبینیهای آنها یک چالش بزرگ خواهد بود. پرابات در توضیح دشوار بودن خواندن این اطلاعات میگوید: «تصور کنید یک ویدئو در یوتیوب، بهمدت ۱۰۰ سال پخش شود. قطعا نمیتوان تمامی اجزای موجود در آن را تنها با دست شمرد».

روشهای سنتی برای بهبود پردازندههای هوش مصنوعی کاربردی نیستند

نرمافزارهایی که قبلا برای خودکارسازی فرایند خواندن اطلاعات استفاده میشدند، برای پروژهی پیشبینی اقلیمی، کاربرد زیادی نداشتند. نتایج ابرکامپیوتر سامیت نشان داد که هوش مصنوعی، این کار را بهتر انجام میدهد و در نتیجه، میتوان عواقب تغییرات اقلیمی همچون سیل و زلزله را نیز بهتر تحلیل کرد. بههرحال تحقیقات انجامشده، جایزهی Gordon Bell را بهخاطر توسعهی مرزهای پردازش ابرکامپیوتری برای مؤسسهی اوک ریج، دانشگاه لارنس برکلی و دانشمندان انویدیا بههمراه داشت.

پیادهسازی یادگیری عمیق در ابرکامپیوترها، ایدهای است که در زمان مناسب به کمک محققان آبوهوایی آمد. مایکل پیچارد، یکی از اساتید دانشگاه کالیفرنیا، ایروین چنین اعتقادی دارد. از نظر او، کاهش سرعت بهبود پردازندههای سنتی، مهندسان را به استفاده از پردازندههای گرافیکی مدرن در ابرکامپیوترها سوق داد که کاراییشان با سرعت بیشتری در این سالها بهبود داشته است. پیچارد در ادامهی صحبتهایش میگوید: «در ساختار سنتی، به نقطهای رسیده بودیم که نمیشد قدرت پردازش را با روشهای عادی بهبود بخشید».

تغییر مسیر دانشمندان به پردازندههای گرافیکی، چالشهایی را برای شبیهسازیهای سنتی بههمراه داشت و آنها را مجبور به همگام شدن با حرکت جدید کرد. بههرحال، درهای جدیدی هم در علم باز شد که منجر به پی بردن به ارزشهای بالای یادگیری عمیق شدند. یادگیری عمیق، به بهترین نحو از قدرت پردازش پردازندههای گرافیکی بهره میبرد و دستاوردهای جدید در آن حوزه، به نفع صنعت پردازندهی گرافیکی نیز خواهد بود.

تحقیقات فوق و دستاوردهای آن، دید مناسبتری نسبت به تغییرات آتی آبوهوایی به ما میدهد. گروه پیچارد، سال گذشته نشان دادند که یادگیری عمیق میتواند شبیهسازیهای واقعیتری از ابرها در پیشبینیهای آبوهوایی ارائه کند. در نتیجهی آن، پیشبینی تغییر الگوهای بارشی نیز آسانتر خواهد شد.