موفقیت هوش مصنوعی مایکروسافت در رنگیکردن ویدئوها فقط با یک تصویر

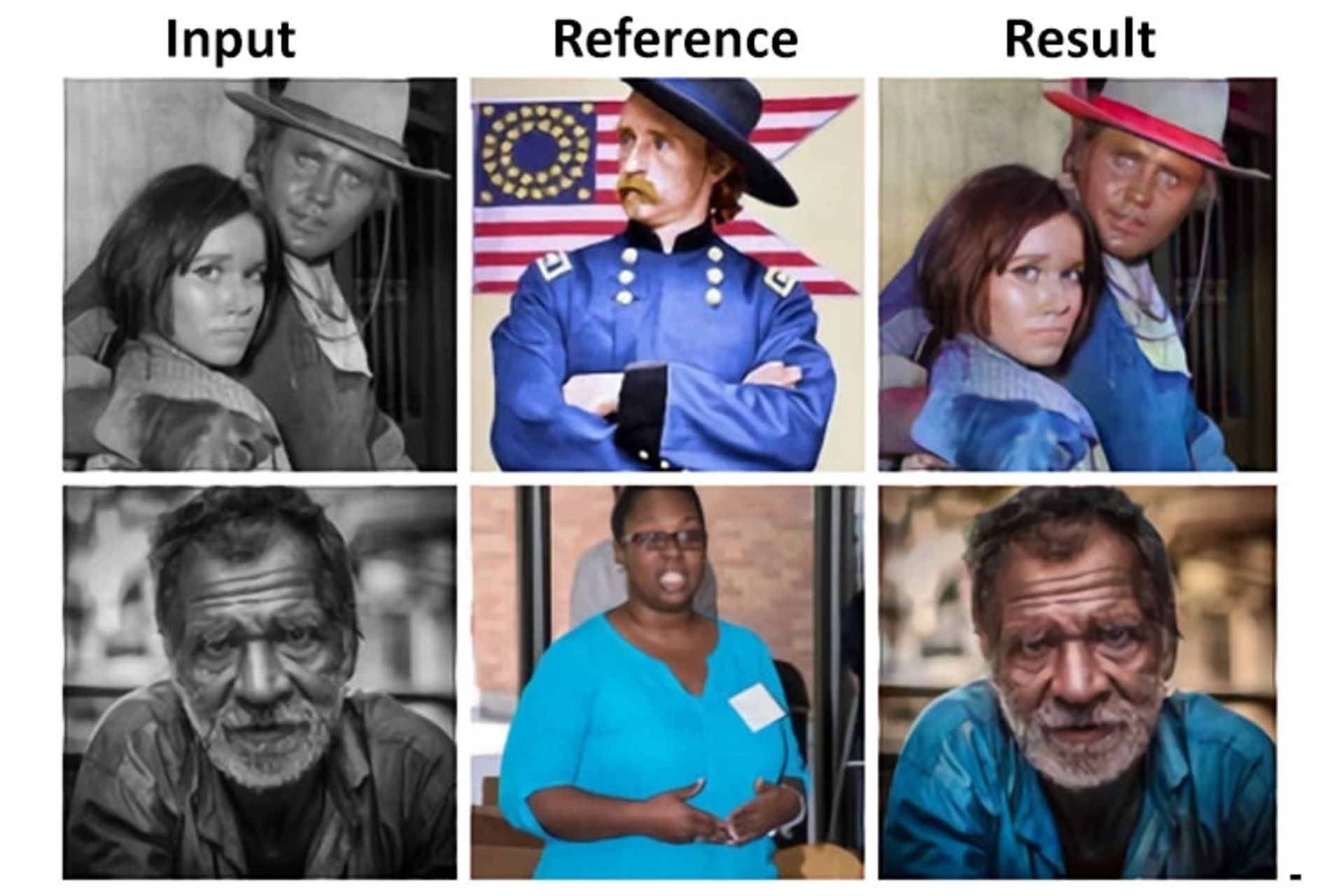

رنگیکردن ویدئوها ممکن است اثری هنری قلمداد شود. امروزه، مدلهای جدید هوش مصنوعی کمکم به این حوزه نیز وارد شدند و میتوانند اثری هنری خلق کنند. تیم دانشمندان مایکروسافت با همکاری دانشگاه حمدبنخلیفه و مؤسسهی USC در بخشهای تحقیقات آسیا (Research Asia) و ادراک هوش مصنوعی (AI Perception) و بخش واقعیت ترکیبی (Mixed Reality Division) پژوهشی جدید انجام داد و مقالهای با عنوان رنگیکردن ویدئوها مبتنیبر نمونهی مرجع (Deep Exemplar-based Video Colorization) در وبسایت Arxiv منتشر کرد. این پژوهش جدید دستاوردی در حوزهی فناوریهای خلاقانه است و پژوهشگران این تیم ادعا میکنند موفق شدند اولین سیستم سرتاسری مستقلِ مبتنیبر نمونه (مثلا برگرفته از تصویری مرجع) را در رنگیکردن ویدئوها ایجاد کنند. بهگفتهی پژوهشگران مایکروسافت، این تحقیقات در هر دو بخش کمّی و کیفی به نتایجی فراتر از اثری هنری دست پیدا کرده است.

نویسندگان این مقاله معتقدند:

مسئلهی اصلی چگونگی دستیابی به ثبات زمانی (Temporal Consistency) است؛ درحالیکه بتوان به سبک و ویژگیهای تصویر مرجع وفادار ماند. تمام بخشهای مختلف این مدل هوش مصنوعی که بهصورت سیستم سرتاسری آموزش داده شده، باعث ایجاد ویدئوهای واقعی با پایداری زمانی (Temporal Stability) مناسب میشود.

نویسندگان این مقاله خاطرنشان کردند توانایی هوش مصنوعی در تبدیل ویدئوهای تکرنگی به ویدئوهای رنگی کار جدیدی نیست. برای نمونه، پژوهشگران انویدیا یکی از بزرگترین شرکتهای فناوری جهان و غول پردازندههای گرافیکی، در سپتامبر گذشته موفق شدند مدلی ارائه کنند که رنگها را از فریم فقط یک ویدئو رنگیشده استخراج میکرد. نمونهی دیگر، هوش مصنوعی گوگل است که در ژوئن با ارائهی الگوریتمی، ویدئوهای سیاهوسفید را بدون نظارت دستی انسان رنگی میکرد. بااینحال، نکتهی اصلی این است که خروجی تمام این مدلها و الگوریتمهای ارائهشده خطاها و آرتیفکتهای بسیار دارد که مدت زمان ویدئو ورودی را افزایش میدهد.

برای مشاهدهی ابعاد اصلی روی تصویر کلیک کنید.

در روش جدید برای کاهش نقصها، نتیجهی فریم ویدئوی قبلی بهعنوان ورودی (برای حفظ ثبات) بهکار گرفته میشود و رنگیسازی با استفاده از تصویر مرجعی انجام میگیرد، بدین ترتیب این تصویر فرایند رنگیسازی را فریمبهفریم هدایت میکند و خطای تجمعی را کاهش میدهد. در بیشتر مدلهای قبلی، رنگ صحیح اجسام درون تصویر را نمیشد بهصورت مستقیم از تصویر سیاهوسفید بهدست آورد؛ بنابراین، هوش مصنوعی باید میتوانست نوع و رنگ اجسام را ازطریق یادگیری ماشینی که از چند میلیون عکس رنگی بهدست آورد و بهدرستی پیشبینی کند. در مدل جدید، هنگام جلورفتن فریمبهفریم ویدئو، رنگ فریمها تغییر نمیکند؛ یعنی رنگ جدید محتوای ویدئویی سیاهوسفید با جلورفتن ویدئو در فریمهای بعدی ثابت باقی میماند. اگر تصویر مرجع یک فریم رنگی در ویدئو باشد، این کار همانند بسیاری دیگر از روشهای رنگیکردن ویدئوها، اما بسیار قدرتمندتر و با دقت بیشتری انجام میشود؛ درنتیجه، این مدل جدید میتواند رنگهای «طبیعی» را براساس معانی ورودی تصویر سیاهوسفید پیشبینی کند. این مدل حتی میتواند زمانیکه تطبیق مناسبی در تصویر مرجع یا فریم قبلی ارائه نشده باشد، پیشبینی مناسبی از معنای رنگ کند.

دستیابی به چنین مدلی نیازمند معماری شبکهی کانولوشن سرتاسری است. شبکهی کانولوشن سرتاسری نوعی سیستم هوش مصنوعی است که برای تجزیهوتحلیل تصاویر دیداری از آن استفاده میشود و همراهبا ساختاری مکرر است که اطلاعات تاریخی ازنظر زمانی را حفظ میکند. این مدل از دو ماژول تشکیل شده است: ۱. مدل Correspondence که تراز تصویر مرجع را در فریم ورودی متناسب با معنای تراکم رنگ تنظیم میکند؛ ۲. مدل رنگیکردن ویدئوها است که باتوجهبه نتیجهی رنگیشدن فریم فبلی و تراز تصویر مرجع، فریم ویدئو سیاهوسفید را رنگی میکند.

تیم تحقیقاتی مجموعهای از دادههای آموزشدیده را از مجموعهی متنباز Videvo گردآوری کردند که بیشتر شامل تصاویر حیوانات و مناظر بودند. آنها پرتره ویدئوها را با استفاده از مجموعهی جداگانهای (هالیوود ۲) کامل کردند و مجموع ۷۶۸ ویدئویی را فیلتر کردند که بیشازحد تصویر آنها تاریک بود یا رنگ محوی داشتند. برای هر ویدئو، ۲۵ فریم استخراج شد و دستهبندی دادهها را با عکسهای ImageNet، مرکز دادهی وسیعی برای توسعهی نرمافزارهای هوش مصنوعی گسترش دادند که برای اعمال تحریف هندسی تصادفی و مشخصکردن نویزها برای تولید فریمها استفاده میشدند. نتیجهی نهایی، تولید ۷۰ هزار ویدئو تکمیلشده در «دستهبندیهای گوناگون» بود.

بهگزارش نویسندگان این مقاله، در آزمایشهای انجامشدهی این سیستم جدید، بهترین دقت کلاس Top-5 و Top-1 در ImageNet ارائه شده است. این نشاندهندهی آن است که نتایج ازنظر معنایی معنادار بوده و آن را با کمترین مقدار Frechet Inception Distance یا FID درمقایسهبا معیارهای بنچمارک مدیریت کرده که این کار باعث میشود خروجی بسیار واقعیتر باشد.

پژوهشگران گفتند:

بهطورکلی، نتایج این مدل وایبرنت رنگی کمی دارند؛ اما شباهت زیادی با رنگهای زمینه عکس مرجع دارند. همچنین، این روش جدید در مقایسهی کیفی نیز نتایج واقعیتری با وایبرنت رنگیسازی کمتری تولید میکند. علاوهبراین در هر فریم، وایبرنتهای رنگی با آرتیفکتهای بسیار کمتری درمقایسهبا مدلهای قبلی وجود دارند. درعینحال، فریمهای متوالی رنگی نشان میدهد هماهنگی ثبات زمانی مناسبی دارد.