موفقیت هوش مصنوعی مایکروسافت در درک زبان طبیعی

درک زبان طبیعی که به اختصار NLU خوانده میشود، یکی از مهمترین اهداف در حال اجرای هوش مصنوعی است. تلاش هوش مصنوعی برای درک زبان طبیعی به سالهای ۱۹۵۰ برمیگردد، زمانیکه آزمون تورینگ برای ارزیابی میزان هوشمندی یک عامل هوشمند به کار میرفت. آزمون تورینگ، یکی از رایجترین روشهای ارزیابی هوش مصنوعی است. در سالهای اخیر نتایج بسیار امیدوارکنندهای از تکالیف درک زبان طبیعی در پروژههای تحقیقاتی در دانشگاهها و هم بهصورت کاربردی در صنعت مشاهده شده، زیرا نتایج پیشرفتهایی که در حوزه یادگیری عمیق حاصل شده، به حوزه مطالعاتی درک زبان طبیعی اعمال شده، مانند مدل زبانی BERT که گوگل در سال ۲۰۱۸ توسعه داده است.

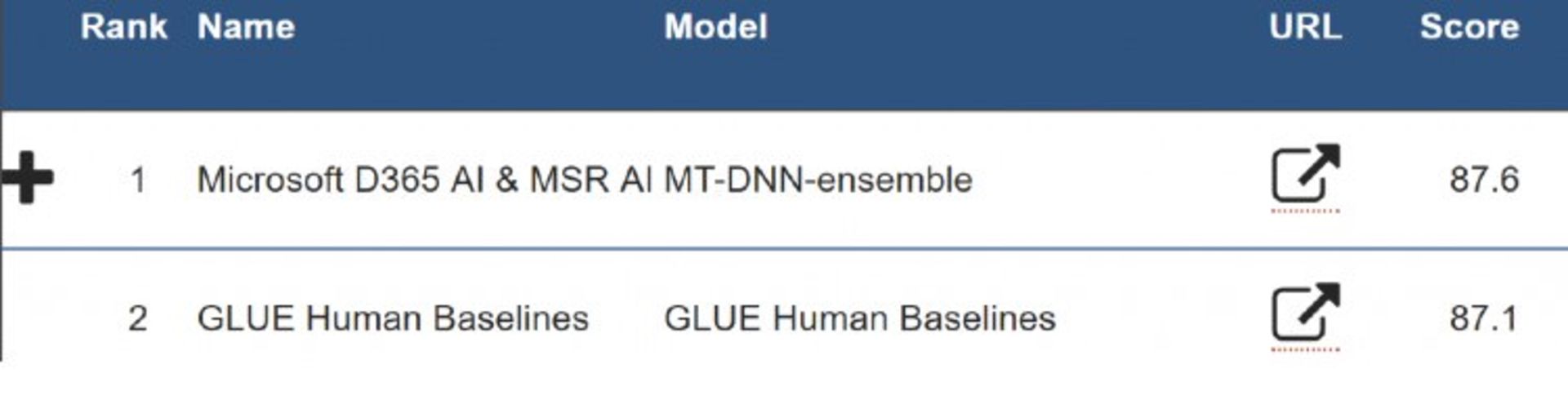

ارزشیابی درک زبان عمومی که به اختصار GLUE خوانده میشود، یک بنچمارک شناختهشده است که شامل ۹ تکلیف درک زبان طبیعی است. این ۹ تکلیف زبانی شامل پرسش و پاسخ، تجزیه و تحلیل احساسات، شباهت متنی و استلزام متنی هستند که بهخوبی برای ارزیابی تعمیم و استحکام مدلهای درک زبان طبیعی طراحی شده است. از زمان انتشار در اوایل سال ۲۰۱۸، بسیاری از مدلهای پیشرفته درک زبان طبیعی (قبلی) مانند BERT،GPT،Stanford Snorkel و MT-DNN همانطور که روی جدول ردهبندی GLUE نمایش داده شده است، روی آن معیار شدهاند. تیمهای تحقیقاتی برتر دنیا در حال همکاری برای توسعه مدلهای جدید بسیار نزدیک به عملکرد درک زبانی انسان در GLUE هستند.

در چند ماه گذشته، مایکروسافت بهطور قابل توجهی رویکرد MT-DNN را در حوزه درک زبان طبیعی بهبود بخشید و درنتیجه موفق شد در ژوئن ۲۰۱۹ بهطور کلی با نمره متوسط ۸۷.۶ در مقابل ۸۷.۱ نسبت به عملکرد درک زبانی در GLUE پیشی بگیرد. نتیجه حاصلشده از روش MT-DNN بهطور قابل ملاحظهای حتی بهتر از دومین روش با نمره (۸۶.۳) در جدول ردهبندی است.

دلیل موفقیت رویکرد MT-DNN در درجه اول، ترکیب روش جدیدی به نام تکلیف رابط زبان طبیعی وینوگراد (WNLI) است که در آن هوش مصنوعی باید بتواند بهدرستی ضمایر مبهم جملات را شناسایی کند و تشخیص دهد که مرجع آن ضمایر در جملات به کدام اسامی مشخص در جمله بازمیگردد.

برای مثال، در این تکلیف زبانی، جملهای را در اختیار هوش مصنوعی قرار میدهند:

شورای شهر اجازه تظاهرات به تظاهرتکنندگان را نداد، زیرا آنها از خشونت [میترسیدند/ حمایت میکردند].

اگر واژه «ترسیدن» انتخاب شود، بنابراین ضمیر آنها به شورای شهر برمیگردد و اگر واژه «حمایت کردن» انتخاب شود، ضمیر به واژه تظاهرات کنندگان اشاره دارد.

انسانها چنین تکالیف زبانی را براساس شم زبانی خود بهصورت شهودی و با توجه به دانش جهانی خود انجام میدهند اما انجام چنین تکالیفی برای ماشین بسیار دشوار است.

این تکلیف زبانی بهعنوان یکی از چالشبرانگیزترین تکالیف در GLUE به ثبت رسیده است، تا جایی که مدلهای قبلی یادگیری ماشین مانند BERT بهسختی توانستند عملکرد بهتری از سطح ابتدایی با اکثریت آرا (نمره ۶۵.۱) بهدست آورند.

اگرچه نسخههای اولیه MT-DNN (که توسط لیو و همکاران در مقالاتی در سال ۲۰۱۹ به ثبت رسیده است) در حال حاضر نمرات بهتری نسبت به انسانها به دست آوردهاند، اما در چندین تکلیف زبانی مانند MRPC ،QQP و QNI عملکرد بسیار ضعیفتری نسبت به انسان در تکلیف زبانی WNLI داشتند، بهطوری که هوش مصنوعی توانست نمرهی ۶۵.۱ را درمقابل نمرهی ۹۵.۹ انسان کسب کند. بنابراین، پژوهشگران بهطور کلی معتقد هستند که بهبود نمره آزمون در تکلیف زبانی WNLI برای دستیابی به عملکرد درک زبان انسانی براساس نمره کلی در GLUE بسیار حیاتی است. تیم تحقیقاتی مایکروسافت با روشی مبتنی بر مدل جدید یادگیری عمیق به کمک بهبود حل تکلیف WNLI برای هوش مصنوعی آمده است. این مدل میزان واضح بودن ضمایر را با توجه به محاسبه شباهت معنایی بین ضمایر و مرجعهای پیشنهادی در جمله فریم بندی میکند. با استفاده از این روش نمره آزمون نهایی در ماشین به ۸۹.۰ ارتقا یافت. نمره آزمون همراهبا بهبود بخشهای دیگر، بهطور کلی به ۸۷.۶ رسید و توانست در عملکرد درک زبان انسانی در GLUE پیشی بگیرد که نقطه عطفی در جهت رسیدن به هدف درک زبان طبیعی در ماشین محسوب میشود.

دانشمندان بیش از ۸۰ سال است که در حال ساخت سلاحهای هستهای هستند، اما ساخت آنها همچنان چالشبرانگیز است.

جنسیس با خودروهای مفهومی چشمنوازش در نمایشگاه خودرو سئول، نگاهها را خیره کرد.

سونی نسل جدید تلویزیونهای ۲۰۲۵ خود را با ویژگیهای ارتقایافته معرفی کرد.

اگر تاریخ به شکل دیگری رقم خورده بود، شاید حرکت پادساعتگرد به جای حرکت ساعتگرد به یک قاعده تبدیل میشد.

آیفونی را تصور کنید که از هر زاویه شفاف باشد و بتوان از همهی سطوح آن استفاده کرد.

سامسونگ با Awesome Intelligence قابلیتهای هوش مصنوعی جدیدی برای بهبود تصاویر و جستوجوی بهتر و تبدیل متن آنلاین به صدا ارائه میدهد.

در آستانهی پنجاهمین سالگرد مایکروسافت، اظهارات قدیمی بیل گیتس دربارهی یکی از تصمیمهای مهم دوران مدیریتش دوباره در کانون توجه قرار گرفته است.