چرا هوش مصنوعی هنوز توانایی درک رابطه علت و معلولی را ندارد؟

هوش مصنوعی بهخوبی میتواند الگوهایی را از میان دادههای متنوع استخراج کند که ذهن انسان توانایی درک آنها را ندارد. ازطرفی همین هوش هنوز نمیتواند ارتباط بین رخدادهای گوناگون را شناسایی کند. بهعنوان مثال، کودکی که بهتازگی راه رفتن را میآموزد، بهراحتی علت و دلیل یک رخداد را متوجه میشود. درحالیکه هوش مصنوعی بسیار پیشرفته که در خودروهای خودران، هدایت وسیلهی نقلیه را حتی در اتوبانهای شلوغ به دست میگیرد، هنوز علت اتفاقها را متوجه نمیشود.

آزمایشی تجربی روی ساختار هوش مصنوعی نشان میدهد که درک فیزیک ابتدایی و ساختار علت و معلولی برای پیشرفتهترین الگوریتمهای هوش مصنوعی نیز دشواریهای زیادی دارد و حتی غیرممکن محسوب میشود. البته همین مطالعه تلاش میکند تا هوش مصنوعی با توانایی درک «چرایی» رخدادها توسعه دهد. جاش تننبائوم، استاد مرکز Brains Minds & Machines در دانشگاه MIT، مدیریت پروژهی مطالعاتی را برعهده دارد و هدف آن را گسترش تواناییهای ماشین، فراتر از درک الگو بیان میکند. چانگ گان، محقق دیگر دانشگاه MIT و کزین یی، دانشجوی دکترا، تننبائوم را همراهی میکنند. او اعتقاد دارد شرکتهای بزرگ دنیای فناوری، قطعا عاشق هوش مصنوعی میشوند که تواناییهایی فراتر از درک الگوری رایج داشته باشد.

مشهورترین و مرسومترین فناوری هوش مصنوعی، یادگیری عمیق، در سالهای اخیر پیشرفتهای قابلتوجهی را تجربه کرد. درک پیشرفتهای این فناوری باعث شد تا علاقهی کاربران و کارشناسان به ظرفیتهای هوش مصنوعی بیشتر شود. یادگیری عمیق، شامل تزریق حجم زیادی داده به یک شبکهی عصبی میشود تا بتوان از آن برای آموزش هوش مصنوعی استفاده کرد. الگوریتمهای یادگیری عمیق اغلب بهزیبایی الگوی موجود در میان دادهها را کشف میکنند. درواقع یادگیری عمیق باعث توسعهی کاربردهایی عالی در شناسایی صوت و تصویر میشود. البته همین فناوریهای پیشرفته، ظرفیتهایی که برای انسانها حیاتی هستند را شامل ندارند.

تننبائوم و همکارانش برای نشان دادن کمبودهای هوش مصنوعی، یک آزمایش بررسی هوشمندی طراحی کردند. در طول آزمایش، دنیای سادهی مجازی به هوش مصنوعی نمایش داده میشود که تعدادی سوژهی درحال حرکت در آن وجود دارد. سپس، سؤالهای و پاسخهایی پیرامون صحنهی موجود و رخدادهای آن ارائه میشود. سؤالها و پاسخها همگی برچسبزده شدهاند که روندی شبیه به آموزش هوش مصنوعی برای شناسایی تصاویر است.

سیستمهای مجهز به یادگیری ماشین عمیق، در بررسیهای اولیهی جهان مجازی، نقاط ضعف مهمی از خود نشان دادند. سیستم مورد آزمایش در پاسخ به سؤالهای توصیفی مانند شناسایی رنگ یک سوژه، بهخوبی عمل کرد و در ۹۰ درصد مواقع پاسخ صحیح داد. ازطرفی وقتی از همین سیستم سوالی با ساختار علت و معللی پرسیده میشود، عملکرد مناسبی ندارد. بهعنوان مثال وقتی از سیستم بپرسیم «چه چیزی باعث شد تا توپ به مکعب برخورد کند» یا «چه اتفاقی میافتاد اگر اجسام برخورد نمیکردند»، تنها در ۱۰ درصد موارد پاسخ صحیح ارائه میکند.

دیوید کاکس، نمایندهی IBM در MIT-IBM Watson AI Lab که در پروژهی مذکور حضور داشت میگوید درک علیت برای هوش مصنوعی اساسا مهم است. او میگوید «انسانها بهخوبی رابطهی علیت را درک یکنند و سیستمهای هوش مصنوعی نیز باید به این توانایی دست پیدا کنند.

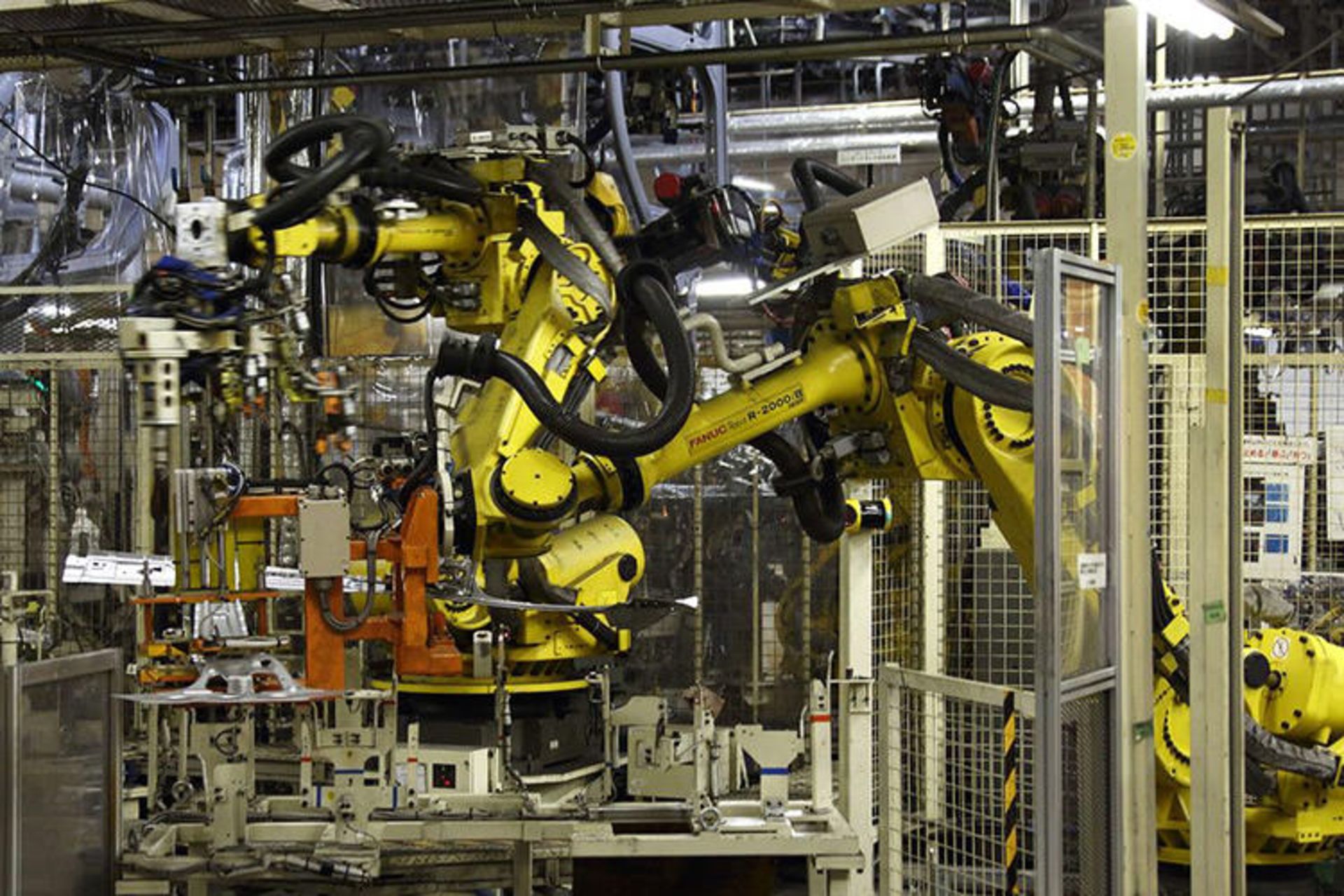

کمبود توانایی درک علیت میتواند عواقب بزرگی در پی داشته باشد. رباتهای صنعتی توانایی شناسایی اجسام نزدیک به خود را دارند. درنتیجه آنها را بهراحتی میگیرند یا حرکت میدهند. البته آنها درک نمیکنند که ضربه زدن به چیزی میتواند باعث افتادن از شکستن آن شود. تنها درصورتیکه برنامهریزیهای پیشرفتهای روی رباتها انجام شود، آنها توانایی درک سناریوهای محدودی را از رابطهی علیت پیدا میکنند. اگر یک ربات، توانایی درک علیت را داشت، میتوانست بدون آمزش دیدن هم از حوادث احتمالی جلوگیری کند. همین گزاره برای خودروهای خودران نیز صدق میکند. هوش مصنوعی داخلی خودرو درصورت درک رابطهی علیت، متوجه میشود که درصورت برخورد یک کامیون با گاردریل جاده، احتمال ریختن بار آن وجود دارد.

توانایی درک رابطهی علیت برای تمامی انواع هوش مصنوعی در کاربردهای متنوع، مفید خواهد بود. سیستمهایی که براساس اطلاعات پزشکی فعالیت میکنند، با درک علیت میتوانند دلیل یک بیماری را شناسایی کرده یا حتی عواقب استفاده از دارو یا روش درمانی خاص را پیشبینی کنند. بههرحال بسیاری از محققان امروزه تلاش میکنند تا درک علیت را به تواناییهای هوش مصنوعی بیفزاند. همهی تلاشها با این هدف صورت میگیرد که هوش مصنوعی، علاوه بر توانایی یادگیری، توانایی استدلال هم پیدا کند.

کان ژانگ، استادیار دانشگاه کارنگی ملون که روی موضوع درک علیت و استدلال در یادیگری ماشین تحقیق میکند، دستاوردهای آزمایش تننبائوم را کاربردی میداند. از نظر او با آزمایش جدید میتوان درک علیت را تاحدی در سیستمهای هوش مصنوعی آزمایش کرد. ژانگ میگوید با اضافه شدن قدرت استدلال، میتوان مسیر را بهسمت هوش مصنوعی جامع هموار کرد.

اضافه کردن توانایی استدلال به هوش مصنوعی، قدم بعدی توسعهی فناوری است

تننبائوم و همکارانش علاوه بر نمایش ناتوانی هوش مصنوعی در درک رابطهی علت و معلولی، سیستمی توسعه دادند که توانایی یادگیری علت و معلول را دارد و در آزمایش تشخیصی، امتیاز بیشتری دریافت میکند. روش آنها با ترکیب تکنیکهای متعدد هوش مصنوعی اجرا میشود. سیستم از یادگیری عنیق برای شناسایی اجسام در یک صحنه بهره میبرد و خروجی آن به نرمافزاری ارسال میشود که مدلی سهبعدی از صحنه و اجسام موجود میسازد.

روش آموزش استدلال به هوش مصنوعی، نسبت به اکثر الگوریتمهای یادگیری ماشین به ابزارهای دستی بیشتری نیاز دارد. تننبائوم میگوید سیستم توسعهیافتهی کنونی اعتبار و دوام بالایی هم ندارد و نمیتوان آن را مقیاسدهی کرد. بههرحال با ترکیب رویکردهای متنوع و استفاده از ایدههای جدید، میتوان هوش مصنوعی را به مرحلهی بعد هم توسعه داد.

برندن لیک، استادیار روانشناسی و علوم داده در دانشگاه نیویورک دربارهی استدلال ذهنی میگوید:

ذهن ما مدلهای استدلالی را میسازد و از آنها برای پاسخ به سؤالهای دلخواه استفاده میکند، درصورتیکه بهترین سیستمهای هوش مصنوعی توانایی ساختن مدل استدلالی را ندارند.

ساموئل گرشمن، استاد دانشگاه هاروارد و از همکاران قدیمی تننبائوم در پروژههای دیگر، اعتقاد دارد نمیتوان بدون اضافه کردن توانایی استدلال، هوش مصنوعی را بهسمت هوش انسانی توسعه داد. او بهعنوان مثال، حقیقتی پزشکی را عنوان میکند. نتایج علمی نشان میدهند زنان کمتر از مردان احتمال مرگ بهخاطر مسمومیت الکلی دارند. گرشمن میگوید اگر این حقیقت را به هوش مصنوعی ارائه کنیم، پیشنهاد میدهد که برای کاهش مرگومیر ناشی از مسمومیت الکل در میان مردان، جنسیت آنها را تغییر دهیم. همین استدلال اولیه و مضحک نشاندهندهی ضعف عمیق هوش مصنوعی در استدلال است.